Tabela de links

Resumo e 1 Introdução

2 terminologia

3 Explorando o espaço de design dos modelos de linguagem da visão e 3.1 Todos os backbones pré-treinados são equivalentes para o VLMS?

3.2 Como a arquitetura totalmente autoregressiva se compara à arquitetura de atendimento cruzado?

3.3 Onde estão os ganhos de eficiência?

3.4 Como um comércio pode calcular o desempenho?

4 IDEFICS2-Um modelo de fundação de última geração de última geração e 4.1 pré-treinamento em várias etapas

4.2 Instruções Ajuste fino e 4.3 Otimizando para cenários de bate-papo

5 Conclusão, reconhecimento e referências

Um apêndice

A.1 detalhes experimentais adicionais das ablações

A.2 Detalhes da instrução Tuneamento fino

A.3 Detalhes das avaliações

A.4 Team vermelho

2 terminologia

Primeiro, estabelecemos terminologia compartilhada para discutir as diferentes opções de design. O Treinamento VLMS normalmente requer colar uma espinha dorsal de visão pré-treinada e um backbone de idioma pré-treinado, inicializando novos parâmetros para conectar as duas modalidades. O treinamento desses novos parâmetros é feito durante a fase de pré-treinamento. Esse estágio geralmente aproveita um grande conjunto de dados multimodais, como pares de capturas de imagem. Observamos que, embora seja mais comum começar de dois backbones pré-treinados unimodais separados, os parâmetros desses dois backbones podem ser opcionalmente compartilhados e inicializados do zero, como feito em (Bavishi et al., 2023). Como na literatura sobre modelos de idiomas, o estágio de pré-treinamento é seguido por um estágio de ajuste fino, no qual o modelo aprende com amostras orientadas para tarefas.

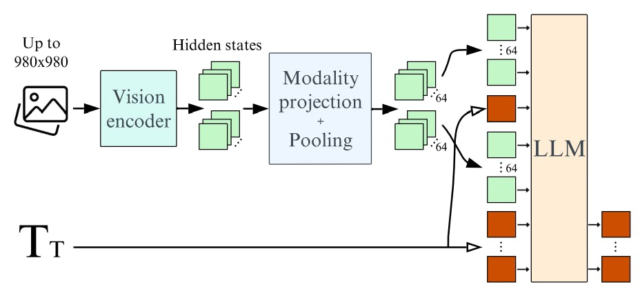

Trabalhos recentes exploram duas opções principais para combinar as entradas visuais e as entradas de texto. Na arquitetura cruzada (Alayrac et al., 2022; Laurençon et al., 2023; Awadalla et al., 2023), as imagens codificadas através do backbone da visão são injetadas em diferentes camadas dentro do modelo de linguagem, intercalando os blocos cruzados nos quais o texto está atento a os estados cruzados. Por outro lado, na arquitetura totalmente autoregressiva (Koh et al., 2023; Driess et al., 2023; Liu et al., 2023), a saída do codificador de visão é diretamente concatenada à sequência de incorporação de texto e toda a sequência é aprovada como entrada para o modelo de linguagem. A sequência de entrada do modelo de linguagem é, portanto, a concatenação de tokens visuais e tokens de texto. A sequência de tokens visuais pode ser opcionalmente agrupada em uma sequência mais curta, fornecendo mais eficiência de computação. Nós nos referimos às camadas que mapeiam o espaço oculto da visão para o espaço oculto do texto como camadas de projeção de modalidade. A Figura 2 destaca a arquitetura totalmente autorregressiva que finalmente usamos para o IDEFICS2.

3 Explorando o espaço de design dos modelos de linguagem da visão

Nesta seção, comparamos as opções de design recorrentes na literatura de modelos de linguagem da visão e destacamos os resultados. A menos que especificado de outra forma, executamos as ablações por 6.000 etapas e relatamos a pontuação média do desempenho de 4 tiros em 4 benchmarks a jusante que medem diferentes capacidades: VQAV2 (Goyal et al., 2017) para respostas gerais de perguntas visuais, TEXTVQA (Singh et al., 2019) para capacidade de OCR, Okvq (Marino et al. legenda.

3.1 Todos os backbones pré-treinados são equivalentes para o VLMS?

Os VLMs mais recentes começam a partir de backbones unimodais pré-treinados. Como a escolha dos backbones (visão e texto) influencia o desempenho do VLM resultante?

Corrigimos o tamanho dos backbones pré-treinados, os dados usados para pré-treinamento multimodal e o número de atualizações de treinamento. Sob a arquitetura de atendimento cruzado, observamos que a maior melhoria no desempenho dos benchmarks de linguagem da visão vem da alteração do modelo de idioma para melhor. Mais especificamente, a substituição da LLAMA-1-7B (Touvron et al., 2023) (35,1% em MMLU (Hendrycks et al., 2021)) por Mistral-7b (Jiang et al., 2023) (60,1% em mmlU) produz um aumento de 5.1 (consulte 1). Além disso, a troca do codificador de visão do clipe-vit-h (Radford et al., 2021) (78,0% no ImageNet (Deng et al., 2009)) para Siglip-So400m (Zhai et al., 2023) (83.2% na imagenet) produz um aumento de 3.3 no desempenho no desempenho na referência no desempenho da referência no desempenho de 2023 (83.2% na imagenet). Este resultado em backbones da melhor visão corrobora as observações de (Karamcheti et al., 2024).

Observamos que Chen e Wang (2022) relatam um aumento mais forte no desempenho, dimensionando o tamanho do codificador de visão em comparação com a escala do tamanho do modelo de linguagem, embora a escala do codificador de visão leve a um aumento de contagem de parâmetros menores. Embora o EVA-CLIP-5B (Sun et al., 2023) seja dez vezes maior em contagens de parâmetros do que o Siglip-So400m (Zhai et al., 2023), obtemos um desempenho semelhante em 4 referências, sugerindo que a comunidade de EVA-5b pode ser bem-treinada e reconhecemos que a comunidade aberta.

Autores:

(1) Hugo Laurençon, abraçando o rosto e Sorbonne Université (a ordem foi escolhida aleatoriamente);

(2) Léo Tronchon, abraçando o rosto (a ordem foi escolhida aleatoriamente);

(3) cordão de Matthieu, Sorbonne Université;

(4) Victor Sanh, abraçando o rosto.