Tabela de links

Resumo e 1. Introdução

- Método proposto: quantizado Dylora

- Experiências e avaliação

- Sobre o comportamento semi-derrotado de Qdylora

- Conclusão, limitações e referências

A. Material suplementar

A.1. Hyperparameters

A.2. Qualidade de texto gerada

5 Conclusão

O QDYLORA oferece uma técnica eficiente e eficaz para os LLMs de ajuste fino baseados em LORA em tarefas a jusante. Eliminando a necessidade de vários modelos de ajuste fino para encontrar a classificação ideal da LORA e oferecer a possibilidade de LLMs maiores de ajuste fino são duas vantagens principais do Qdylora. Os resultados experimentais demonstraram que a classificação ideal para Qdylora pode ser surpreendentemente baixa, mas supera consistentemente Qlora. O QDYLORA oferece maior flexibilidade para a implantação de LLMs em vários contextos e representa um passo promissor para tornar os grandes modelos de idiomas de ajuste fino mais acessíveis e eficientes.

Limitações

Embora o Qdylora de 4 bits apresenta um desempenho notável, fica aquém de alcançar os níveis de desempenho de ajuste fino total. Uma solução possível pode ser dylora quantizada dinâmica (dyqdylora), na qual o nível de quantização também pode variar durante o Finetuning. Em particular, a estratégia de Finetuning pode alternar dinamicamente entre diferentes níveis de quantização com base em um feedback de aprendizado predefinido. Além disso, mais pesquisas são necessárias para investigar o impacto do escalar de Lora e a gama de fileiras subjacentes em Qdylora.

Referências

Armen Aghajanyan, Luke Zettlemoyer e Sonal Gupta. 2020. A dimensionalidade intrínseca explica a eficácia do ajuste fino do modelo de linguagem. ARXIV ARXIV ARXIV: 2012.13255.

Hyung venceu Chung, Le Hou, Shayne Longpre, Barret Zoph, Yi Tay, William Fedus, Eric Li, Xuezhi Wang, Mostafa Dehghani, Siddhartha Brahma, et al. 2022. Modelos de linguagem de instrução-instrução de escala. Arxiv pré -impressão Arxiv: 2210.11416.

Karl Cobbe, Vineet Kosaraju, Mohammad Bavarian, Mark Chen, Heewoo Jun, Lukasz Kaiser, Matthias Plappert, Jerry Tworek, Jacob Hilton, Reiichiro Nakano, et al. 2021. Treinando verificadores para resolver problemas de palavras matemáticas. Arxiv pré -impressão Arxiv: 2110.14168.

Tim Dettmers, Artidoro Pagnoni, Ari Holtzman e Luke ZettleMoyer. 2023. Qlora: Finetuning eficiente de LLMs quantizados. Arxiv pré -impressão Arxiv: 2305.14314.

Ning Ding, Yujia Qin, Guang Yang, Fuchao Wei, Zonghan Yang, Yusheng Su, Shengding Hu, Yulin Chen, Chi-Min Chan, Weize Chen, et al. 2023. Ajuste fina com eficiência de parâmetro de modelos de linguagem pré-tenhada em larga escala. Nature Machine Intelligence, 5 (3): 220–235.

Ali Edalati, Marzieh Tahaei, Ivan Kobyzev, Vahid Partevi Nia, James J Clark e Mehdi Rezagholizadeh. 2022. Krona: ajuste eficiente do parâmetro com adaptador Kronecker. Arxiv pré -impressão Arxiv: 2212.10650.

Junxian He, Chunting Zhou, Xuezhe MA, Taylor Bergkirkpatrick e Graham Neubig. 2021. Em direção a uma visão unificada do aprendizado de transferência eficiente em parâmetro. Arxiv pré -impressão Arxiv: 2110.04366.

Dan Hendrycks, Collin Burns, Steven Basart, Andy Zou, Mantas Mazeika, Dawn Song e Jacob Steinhardt. 2020. Medindo o entendimento maciço da linguagem multitarefa. ARXIV ARXIV ARXIV: 2009.03300.

Neil Houlsby, Andrei Giurgiu, Stanislaw Jastrzebski, Bruna Morrone, Quentin de Laroussilhe, Andrea Gesmundo, Mona Attariyan e Sylvain Gelly. 2019. Learning de transferência com eficiência de parâmetro para PNL. Em Conferência Internacional sobre Aprendizado de Máquina, páginas 2790–2799. Pmlr.

Edward J Hu, Yelong Shen, Phillip Wallis, Zeyuan Allen-Zhu, Yuanzhi Li, Shean Wang, Lu Wang e Weizhu Chen. 2021. Lora: adaptação de baixo rank de grandes modelos de linguagem. ARXIV ARXIV ARXIV: 2106.09685.

Mandar Joshi, Eunsol Choi, Daniel S Weld e Luke Zettlemoyer. 2017. Triviaqa: um conjunto de dados de desafio supervisionado em larga escala para a compreensão da leitura. Arxiv pré -impressão arxiv: 1705.03551.

Andreas Köpf, Yannic Kilcher, Dimitri von Rütte, Sotiris Anagnostidis, Zhi-Rui Tam, Keith Stevens, Abdullah Barhoum, Nguyen Minh Duc, Oliver Stanley, Richárd Nagyfi, et al. 2023. Conversas de assistência aberta-Democratizando o grande alinhamento do modelo de linguagem. ARXIV ARXIV ARXIV: 2304.07327.

Se Jung Kwon, Jeonghoon Kim, Jeongin Bae, Kang Min Yoo, Jin-Hwa Kim, Baeseong Park, Byeongwook Kim, Jung-Woo Ha, Nako Sung e Dongsoo Lee. 2022. Alphatuning: Adaptação parametereeficiente de quantização com reconhecimento de quantização de modelos de linguagem pré-treinados em larga escala. Arxiv pré -impressão arxiv: 2210.03858.

Haokun Liu, Derek Tam, Mohammed Muqeeth, Jay Mohta, Tenghao Huang, Mohit Bansal e Colin A Raffel. 2022. O ajuste fino com poucos eficientes em parâmetro é melhor e mais barato do que o aprendizado no contexto. Avanços nos sistemas de processamento de informações neurais, 35: 1950-1965.

Xiao Liu, Hanyu Lai, Hao Yu, Yifan Xu, Aohan Zeng, Zhengxiao DU, Peng Zhang, Yuxiao Dong e Jie Tang. 2023. Webglm: Para um sistema de resposta a perguntas eficientes com preferências humanas. Arxiv pré -impressão Arxiv: 2306.07906.

Yuning Mao, Lambert Mathias, Rui Hou, Amjad Almahairi, Hao MA, Jiawei Han, Wen-Tau Yih e Madian Khabsa. 2021. Unipelt: Uma estrutura unificada para ajuste do modelo de linguagem com eficiência de parâmetro. Arxiv pré -impressão Arxiv: 2110.07577.

Yi-lin Sung, Jaemin Cho e Mohit Bansal. 2022. LST: Ajuste lateral da escada para aprendizado de transferência eficiente em parâmetro e memória. Avanços nos sistemas de processamento de informações neurais, 35: 12991–13005.

Rohan Taori, Ishaan Gulrajani, Tianyi Zhang, Yann Dubois, Xuechen Li, Carlos Guestrin, Percy Liang e Tatsunori B Hashimoto. 2023. Stanford Alpaca: Um modelo de llama que segue a instrução.

Mojtaba Valipour, Mehdi Rezagholizadeh, Ivan Kobyzev e Ali Ghodsi. 2022. Dylora: ajuste eficiente do parâmetro de modelos pré-treinados usando adaptação dinâmica sem pesquisa sem pesquisa. Arxiv pré -impressão arxiv: 2210.07558.

Yizhong Wang, Yeganeh Kordi, Swaroop Mishra, Alisa Liu, Noah A Smith, Daniel Khashabi e Hannaneh Hajishirzi. 2022. Auto-instrução: alinhando o modelo de linguagem com instruções auto-geradas. Arxiv pré -impressão arxiv: 2212.10560.

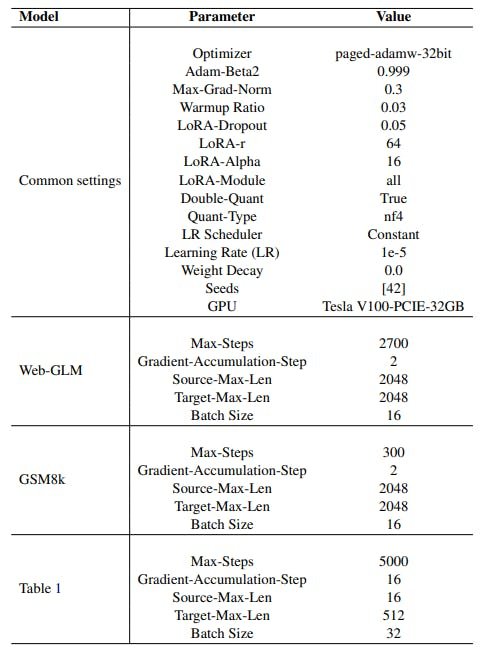

A.1 Hyperparameters

A Tabela 4 fornece uma visão geral dos hiperparâmetros e configurações experimentais empregadas neste estudo, que são configurações cruciais que determinam vários aspectos do processo de treinamento e comportamento do modelo neste estudo. Os parâmetros-chave comuns nos experimentos incluem a escolha do otimizador, o valor de Adam-beta2, a norma máxima de gradiente e a taxa de aquecimento, que influenciam coletivamente como o modelo ajusta seus pesos durante o treinamento. Parâmetros específicos da LORA, como a probabilidade de abandono de Lora, o máximo de classificação Lora e o valor alfa controlam o comportamento das camadas de Lora. Além disso, o tipo de quantização e quantização dupla afeta a precisão das representações numéricas dentro do modelo, que são consideradas as mesmas das linhas de base. A programação da taxa de aprendizado e a deterioração do peso contribuem para o processo de otimização, ajudando a evitar ajuste e estabilizar o treinamento. As sementes aleatórias garantem a reprodutibilidade, enquanto a GPU especificada determina o hardware usado para o treinamento. Cada configuração de modelo, seja para o Web-GLM, GSM8K ou o experimento específico descrito na Tabela 1, apresenta parâmetros adaptados às características do conjunto de dados e aos recursos computacionais disponíveis. Esses hiperparâmetros moldam coletivamente o processo de treinamento, influenciando o desempenho e a eficácia dos modelos no estudo.

A.2 Qualidade de texto gerada

Para descrever a qualidade dos textos gerados por Qdylora, uma consulta de amostra retirada do GSM8K é alimentada ao Falcon-40B treinada por Qdylora. Abaixo, relatamos as respostas geradas para diferentes fileiras da Lora.

Consulta: Os patos de Janet depositam 16 ovos por dia. Ela come três no café da manhã todas as manhãs e assa bolos para seus amigos todos os dias com quatro. Ela vende o restante no mercado dos agricultores diariamente por US $ 2 por ovo de pato fresco. Quanto em dólares ela ganha todos os dias no mercado dos agricultores?

Classificação = 64: Janet tem 16 – 3 – 4 = «16-3-4 = 7» 7 ovos restantes. Ela vende 7 – 16 = «7-16 = 9» 9 ovos no

mercado de agricultores. Ela faz 9 * 2 = «9 * 2 = 18» 18 no mercado dos agricultores todos os dias.

Classificação = 32: Ela come 3 ovos no café da manhã e assa 4 muffins por dia, então usa 3 + 4 = «3 + 4 = 7» 7 ovos por dia. Ela tem 16 – 7 = «16- 7 = 9» 9 ovos restantes a cada dia. Ela vende esses ovos no mercado dos agricultores por US $ 2 por ovo, então faz 2 * 9 = «2 * 9 = 18» 18 por dia no mercado.

Classificação = 28: Ela come 3 ovos no café da manhã e assa 4 muffins por dia, então usa 3+4 = «3+4 = 7» 7 ovos por dia. Ela vende 16-7 = «16-7 = 9» 9 ovos por dia por US $ 2 por ovo. Ela faz 9*2 = «9*2 = 18» 18 por dia no mercado.

Classificação = 16: Os patos de Janet deitam 16 ovos por dia e ela come 3 no café da manhã todas as manhãs, para que ela tenha 16-3 = 13 ovos restantes. Janet assa 4 muffins todos os dias e ela usa 4 ovos para ter 13-4 = 9 ovos restantes. Janet vende os ovos restantes no mercado dos agricultores por US $ 2 cada, então ela ganha 9*2 = «9*2 = 18» 18 dólares por dia. Janet ganha 18 dólares por dia no mercado dos agricultores.

Este artigo é Disponível no Arxiv Sob atribuição de licença internacional de atribuição não comercial.