Tabela de links

Resumo e 1 Introdução

2 especificações técnicas

3 benchmarks acadêmicos

4 Segurança

5 fraqueza

6 Phi-3-Vision

6.1 Especificações técnicas

6.2 Benchmarks acadêmicos

6.3 Segurança

6.4 Fraqueza

Referências

Um exemplo de prompt para benchmarks

B Autores (alfabéticos)

C Agradecimentos

Resumo

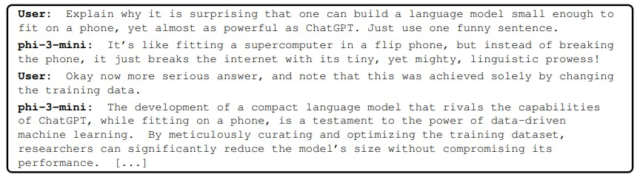

We introduce phi-3-mini, a 3.8 billion parameter language model trained on 3.3 trillion tokens, whose overall performance, as measured by both academic benchmarks and internal testing, rivals that of models such as Mixtral 8x7B and GPT-3.5 (eg, phi-3-mini achieves 69% on MMLU and 8.38 on MT-bench), despite being small enough to be deployed on a phone. A inovação reside inteiramente em nosso conjunto de dados para treinamento, uma versão dimensionada da usada para PHI-2, composta por dados da Web publicamente disponíveis fortemente filtrados e dados sintéticos. O modelo também está ainda alinhado para o formato de robustez, segurança e bate -papo. Também fornecemos alguns resultados iniciais de escala de parâmetros com modelos 7B e 14B treinados para tokens de 4,8T, chamados PHI-3-SMALL e PHI-3-3-MEDIUM, ambos significativamente mais capazes que Phi-3-mini (por exemplo, respectivamente 75% e 78% em MMLU e 8,7 e 8,9 na bancada). Além disso, também introduzimos o Phi-3-Vision, um modelo de parâmetro de 4,2 bilhões baseado em Phi-3-mini com fortes recursos de raciocínio para prompts de imagem e texto.

1 Introdução

O progresso impressionante da IA nos últimos anos pode ser amplamente atribuído a grandes esforços em todo o mundo, em direção a modelos e conjuntos de dados cada vez maiores. Os grandes modelos de linguagem (LLMs) aumentaram constantemente em tamanho a partir de meros bilhões de parâmetros há apenas cinco anos (o GPT-2 tinha 1,5 bilhão de parâmetros [RWC+ 19]) para trilhões de parâmetros hoje. O ímpeto para esse esforço se origina na melhoria aparentemente previsível que se obtém ao treinar grandes modelos, as chamadas leis de escala [KMH+ 20, HBM+ 22, MRB+ 23]. No entanto, essas leis assumem uma fonte de dados “fixa”. Essa suposição agora é significativamente interrompida pela existência dos próprios LLMs de Frontier, que nos permitem interagir com os dados de maneiras novas. Em nossos trabalhos anteriores nos modelos Phi [GZA+ 23, LBE+ 23, JBA+ 23] Foi demonstrado que uma combinação de filtragem baseada em LLM de dados da Web publicamente disponíveis e dados sintéticos criados por LLM, permitem o desempenho em modelos de linguagem menores que normalmente eram vistos apenas em modelos muito maiores. Por exemplo, nosso modelo anterior treinado nesta receita de dados, PHI-2 (2,7B parâmetros), correspondeu ao desempenho dos modelos 25 vezes maior treinado em dados regulares. Neste relatório, apresentamos um novo modelo, Phi-3-mini (3,8B parâmetros), treinado para tokens de 3,3T em versões maiores e mais avançadas dos conjuntos de dados usados no PHI-2. Com seu tamanho pequeno, o Phi-3-mini pode ser facilmente inferido localmente em um telefone moderno (veja a Figura 2), mas atinge uma qualidade que parece no par com modelos como o mixtral 8x7b [JSR+ 24] e GPT-3.5.

Autores:

(1) Marah Abdin;

(2) Sam Ade Jacobs;

(3) Ammar Ahmad Awan;

(4) Jyoti Aneja;

(5) Ahmed Awadallah;

(6) Hany Awadalla;

(7) Nguyen Bach;

(8) Amit Bahree;

(9) Arash Bakhtiari;

(10) Jianmin Bao;

(11) Harkirat Behl;

(12) Alon Benhaim;

(13) Misha Bilenko;

(14) Johan Bjorck;

(15) Sébastien Bubeck;

(16) Qin Cai;

(17) Martin Cai;

(18) Caio César Teodoro Mendes;

(19) Weizhu Chen;

(20) Vishrav Chaudhary;

(21) Dong Chen;

(22) Dongdong Chen;

(23) Yen-Chun Chen;

(24) Yi-Ling Chen;

(25) Parul Chopra;

(26) Xiyang Dai;

(27) Allie del Giorno;

(28) Gustavo de Rosa;

(29) Matthew Dixon;

(30) Ronen Eldan;

(31) Victor Fragoso;

(32) Dan Iter;

(33) Mei Gao;

(34) Min Gao;

(35) Jianfeng Gao;

(36) Amit Garg;

(37) Abhishek Goswami;

(38) Suriya Gunasekar;

(39) Emman Haider;

(40) Junheng Hao;

(41) Russell J. Hewett;

(42) Jamie Huynh;

(43) Mojan Javaheripi;

(44) Xin Jin;

(45) Piero Kauffmann;

(46) Nikos Karampatziakis;

(47) Dongwoo Kim;

(48) Mahoud Khademi;

(49) Lev Kurilenko;

(50) James R. Lee;

(51) Yin Tat Lee;

(52) Yuanzhi Li;

(53) Yunsheng Li;

(54) Chen Liang;

(55) Lars Liden;

(56) CE Liu;

(57) Mengchen Liu;

(58) Weishung Liu;

(59) Eric Lin;

(60) zeqi lin;

(61) Chong Luo;

(62) Piyush Madan;

(63) Matt Mazzola;

(64) Arindam Mitra;

(65) Hardik Modi;

(66) Anh Nguyen;

(67) Brandon Norick;

(68) Barun Patra;

(69) Daniel Perez-Becker;

(70) Thomas Portet;

(71) Reid Pryzant;

(72) Heyang Qin;

(73) Marko Radmilac;

(74) Corby Rosset;

(75) Sambudha Roy;

(76) Olatunji Ruwase;

(77) Olli Saarikivi;

(78) Amin Saied;

(79) Adil Salim;

(80) Michael Santacroce;

(81) Shital Shah;

(82) Ning Shang;

(83) Hiteshi Sharma;

(84) Swadheen Shukla;

(85) Song Xia;

(86) Masahiro Tanaka;

(87) Andrea Tupini;

(88) Xin Wang;

(89) Lijuan Wang;

(90) Chunyu Wang;

(91) Yu Wang;

(92) Rachel Ward;

(93) Guanhua Wang;

(94) Philipp Witte;

(95) Haiping Wu;

(96) Michael Wyatt;

(97) bin xiao;

(98) pode xu;

(99) Jiahang Xu;

(100) Weijian Xu;

(101) Sonali Yadav;

(102) fã Yang;

(103) Jianwei Yang;

(104) Ziyi Yang;

(105) Yifan Yang;

(106) Donghan Yu;

(107) Lu Yuan;

(108) Chengruidong Zhang;

(109) Cyril Zhang;

(110) Jianwen Zhang;

(111) Ly Lyna Zhang;

(112) Yi Zhang;

(113) Yue Zhang;

(114) Yunan Zhang;

(115) Xiren Zhou.