Tabela de links

Resumo e 1 Introdução

2 especificações técnicas

3 benchmarks acadêmicos

4 Segurança

5 fraqueza

6 Phi-3-Vision

6.1 Especificações técnicas

6.2 Benchmarks acadêmicos

6.3 Segurança

6.4 Fraqueza

Referências

Um exemplo de prompt para benchmarks

B Autores (alfabéticos)

C Agradecimentos

5 fraqueza

Em termos de recursos de LLM, enquanto Phi-3-mini O modelo atinge um nível semelhante de compreensão e capacidade de raciocínio de idiomas como modelos muito maiores, ainda é fundamentalmente limitado pelo seu tamanho para determinadas tarefas.

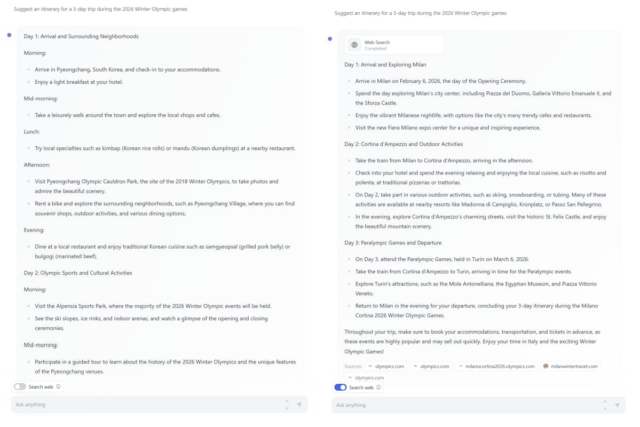

O modelo simplesmente não tem capacidade de armazenar muito “conhecimento factual”, que pode ser visto, por exemplo, com baixo desempenho no Triviaqa. No entanto, acreditamos que essa fraqueza pode ser resolvida por aumento com um mecanismo de pesquisa. Mostramos um exemplo usando o huggingface padrão chat-ui com Phi-3-mini Na Figura 5. Outra fraqueza relacionada à capacidade do modelo é que restringimos principalmente o idioma ao inglês. Explorar recursos multilíngues para modelos de linguagem pequenos é um próximo passo importante, com alguns resultados promissores iniciais em phi-3-small incluindo mais dados multilíngues.

Apesar de nossos esforços diligentes da RAI, como na maioria dos LLMs, permanece desafios em torno de imprecisões factuais (ou alucinações), reprodução ou amplificação de vieses, geração inadequada de conteúdo e questões de segurança. O uso de dados de treinamento cuidadosamente com curadoria e o pós-treinamento direcionado e as melhorias das idéias de equipes vermelhas atenuam significativamente esses problemas em todas as dimensões. No entanto, há um trabalho significativo pela frente para enfrentar completamente esses desafios, e o uso a jusante dos modelos deve ser avaliado quanto aos casos de uso específicos e considerações de segurança para esse contexto.

Autores:

(1) Marah Abdin;

(2) Sam Ade Jacobs;

(3) Ammar Ahmad Awan;

(4) Jyoti Aneja;

(5) Ahmed Awadallah;

(6) Hany Awadalla;

(7) Nguyen Bach;

(8) Amit Bahree;

(9) Arash Bakhtiari;

(10) Jianmin Bao;

(11) Harkirat Behl;

(12) Alon Benhaim;

(13) Misha Bilenko;

(14) Johan Bjorck;

(15) Sébastien Bubeck;

(16) Qin Cai;

(17) Martin Cai;

(18) Caio César Teodoro Mendes;

(19) Weizhu Chen;

(20) Vishrav Chaudhary;

(21) Dong Chen;

(22) Dongdong Chen;

(23) Yen-Chun Chen;

(24) Yi-Ling Chen;

(25) Parul Chopra;

(26) Xiyang Dai;

(27) Allie del Giorno;

(28) Gustavo de Rosa;

(29) Matthew Dixon;

(30) Ronen Eldan;

(31) Victor Fragoso;

(32) Dan Iter;

(33) Mei Gao;

(34) Min Gao;

(35) Jianfeng Gao;

(36) Amit Garg;

(37) Abhishek Goswami;

(38) Suriya Gunasekar;

(39) Emman Haider;

(40) Junheng Hao;

(41) Russell J. Hewett;

(42) Jamie Huynh;

(43) Mojan Javaheripi;

(44) Xin Jin;

(45) Piero Kauffmann;

(46) Nikos Karampatziakis;

(47) Dongwoo Kim;

(48) Mahoud Khademi;

(49) Lev Kurilenko;

(50) James R. Lee;

(51) Yin Tat Lee;

(52) Yuanzhi Li;

(53) Yunsheng Li;

(54) Chen Liang;

(55) Lars Liden;

(56) CE Liu;

(57) Mengchen Liu;

(58) Weishung Liu;

(59) Eric Lin;

(60) zeqi lin;

(61) Chong Luo;

(62) Piyush Madan;

(63) Matt Mazzola;

(64) Arindam Mitra;

(65) Hardik Modi;

(66) Anh Nguyen;

(67) Brandon Norick;

(68) Barun Patra;

(69) Daniel Perez-Becker;

(70) Thomas Portet;

(71) Reid Pryzant;

(72) Heyang Qin;

(73) Marko Radmilac;

(74) Corby Rosset;

(75) Sambudha Roy;

(76) Olatunji Ruwase;

(77) Olli Saarikivi;

(78) Amin Saied;

(79) Adil Salim;

(80) Michael Santacroce;

(81) Shital Shah;

(82) Ning Shang;

(83) Hiteshi Sharma;

(84) Swadheen Shukla;

(85) Song Xia;

(86) Masahiro Tanaka;

(87) Andrea Tupini;

(88) Xin Wang;

(89) Lijuan Wang;

(90) Chunyu Wang;

(91) Yu Wang;

(92) Rachel Ward;

(93) Guanhua Wang;

(94) Philipp Witte;

(95) Haiping Wu;

(96) Michael Wyatt;

(97) bin xiao;

(98) pode xu;

(99) Jiahang Xu;

(100) Weijian Xu;

(101) Sonali Yadav;

(102) fã Yang;

(103) Jianwei Yang;

(104) Ziyi Yang;

(105) Yifan Yang;

(106) Donghan Yu;

(107) Lu Yuan;

(108) Chengruidong Zhang;

(109) Cyril Zhang;

(110) Jianwen Zhang;

(111) Ly Lyna Zhang;

(112) Yi Zhang;

(113) Yue Zhang;

(114) Yunan Zhang;

(115) Xiren Zhou.