Tabela de links

Resumo e 1. Introdução

2 conceitos em dados de pré -treinamento e frequência de quantificação

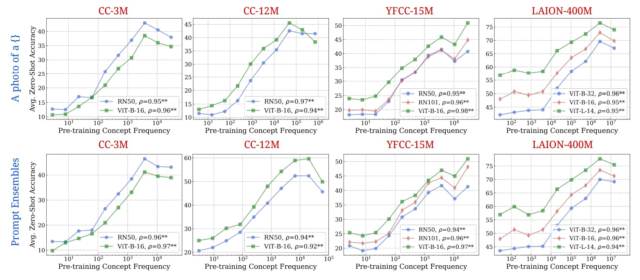

3 Comparando a frequência de pré-treinamento e o desempenho “zero tiro” e a configuração experimental 3.1

3.2 Resultado: A frequência de pré-treinamento é preditiva de desempenho “zero tiro”

4 Testes de estresse A tendência de escala de desempenho de frequência conceitual e 4.1 controlando amostras semelhantes em dados pré-treinamento e a jusante

4.2 Generalização de teste para conceito puramente sintético e distribuições de dados

5 idéias adicionais de frequências de conceito de pré -treinamento

6 Testando a cauda: Deixe -a abanar!

7 Trabalho relacionado

8 Conclusões e problemas abertos, reconhecimentos e referências

Parte I.

Apêndice

A. A frequência do conceito é preditiva de desempenho em estratégias de promoção

B. A frequência do conceito é preditiva de desempenho nas métricas de recuperação

C. A frequência conceitual é preditiva de desempenho para modelos T2i

D. A frequência do conceito é preditiva de desempenho entre conceitos apenas de domínios de imagem e texto

E. Detalhes experimentais

F. Por que e como usamos o RAM ++?

G. Detalhes sobre resultados de grau de desalinhamento

Modelos H. T2i: Avaliação

I. Resultados da classificação: deixe -o abanar!

Efeito dos dados pré-treinamento sobre dados a jusante. Vários trabalhos anteriores centrados em dados [91, 46, 82, 42, 83, 74, 124, 125, 135, 109, 78, 92, 99, 100, 38, 26, 95] destacaram a importância dos dados pré -treinamento para afetar o desempenho. Fang et al. [42] Demonstrou de forma robusta que a diversidade de dados pré-treinamento é a principal propriedade subjacente ao forte comportamento de generalização fora da distribuição do clipe. Da mesma forma, Berlot-Attwell et al. [16] mostrou que a diversidade de atributos é crucial para a generalização composicional [60]nomeadamente sistemática [45]. Nguyen et al. [82] estendeu o Fang et al. [42] A análise para mostrar que as diferenças nas distribuições de dados podem alterar previsivelmente o desempenho do modelo e que esse comportamento pode levar a estratégias eficazes de mistura de dados no tempo de pré -treinamento. Mayilvahanan et al. [79] Completou essa direção de pesquisa, mostrando que o desempenho do Clip está correlacionado com a semelhança entre conjuntos de dados de treinamento e teste. Udandarao et al. [118] Além disso, a frequência de certos tipos de dados visuais no conjunto de dados LAION-2B estava aproximadamente correlacionada com o desempenho dos modelos de clipe na identificação de tipos de dados visuais. Nossas descobertas mais identificam que a frequência de ocorrências conceituais é um indicador -chave de desempenho. Isso complementa a pesquisa existente em áreas específicas, como a resposta a perguntas [62] e raciocínio numérico [94] Em grandes modelos de linguagem, onde o alto conjunto de testes de trem similaridade não explica totalmente os níveis de desempenho observados [127]. Simultaneamente ao nosso trabalho, Parashar et al. [86] Explore também o problema de conceitos de cauda longa no conjunto de dados LAION-2B e como isso afeta o desempenho dos modelos de clipes, apoiando nossas descobertas. Em contraste com o trabalho deles, analisamos a contagem separadamente nas modalidades de imagem e texto, bem como nos conjuntos de pré -treinamento, e fazemos uma série de experimentos de controle para testar minuciosamente a robustez do nosso resultado. Finalmente, nossa demonstração de que a cauda longa produz uma tendência log-linear indica explicitamente a ineficiência da amostra exponencial em modelos pré-tenhados em larga escala.

Análises centradas em dados. Nosso trabalho também aumenta a infinidade de trabalhos que visa entender e explorar a composição de conjuntos de dados em larga escala e usa dados como um meio para melhorar as tarefas a jusante. Trabalhos anteriores observaram a importância dos dados para melhorar o desempenho do modelo em um conjunto generalizado de tarefas [46, 11, 40, 13, 106]. Por exemplo, vários trabalhos utilizam dados recuperados e sintéticos para adaptar modelos de fundação em um amplo conjunto de tarefas a jusante [119, 54, 115, 21, 101, 134, 90]. Maini et al. [76] observaram a existência de clusters “texticric” no Laion-2b e mediram seu impacto no desempenho a jusante. Outro trabalho procurou direcionar o problema de desalinhamento que quantificamos na guia. 3 Por recapitação explícita de conjuntos de dados pré -treinos [68, 28, 120, 131, 83, 17]. Além disso, estudos também mostraram que, por melhores estratégias de poda de dados, as leis de escala neural podem ser mais eficientes do que uma lei de energia [109, 10]. Trabalhos anteriores também mostraram que conjuntos de dados em larga escala sofrem de extrema redundância em conceitos e altos graus de conteúdo tóxico e tendencioso [39, 116]. Mais pesquisas mostraram os efeitos a jusante que tais vieses durante a pré-treinamento induzem nos modelos de última geração [19, 104, 18, 47]. Nosso trabalho aborda a questão dos conceitos de cauda de longa duração em conjuntos de dados pré-treinamento e mostra que essa é uma direção importante de pesquisa para concentrar os esforços.

Autores:

(1) Vishaal Udandarao, Tubingen AI Center, Universidade de Tubingen, Universidade de Cambridge e contribuição igual;

(2) Ameya Prabhu, Tubingen AI Center, Universidade de Tubingen, Universidade de Oxford e Igualista;

(3) Adhiraj Ghosh, Tubingen AI Center, Universidade de Tubingen;

(4) Yash Sharma, Tubingen AI Center, Universidade de Tubingen;

(5) Philip HS Torr, Universidade de Oxford;

(6) Adel Bibi, Universidade de Oxford;

(7) Samuel Albanie, Universidade de Cambridge e Aconselhamento Igual, Ordem decidida por um flip de moedas;

(8) Matthias Bethge, Tubingen AI Center, Universidade de Tubingen e Aconselhamento Igual, Ordem decidida por uma moeda.