Autores:

(1) Evan Shieh, Younger Information Scientists League ([email protected]);

(2) Faye-Marie Vassel, Universidade de Stanford;

(3) Cassidy Sugimoto, Escola de Política Pública do Instituto de Tecnologia da Geórgia;

(4) Thema Monroe-White, Escola de Política e Governo e Ciência da Computação da Schar, Universidade George Mason ([email protected]).

Tabela de hyperlinks

Resumo e 1 Introdução

1.1 Trabalho e contribuições relacionadas

2 métodos e coleta de dados

2.1 Proxies de identidade textual e danos sociopsicológicos

2.2 Modelando gênero, orientação sexual e raça

3 Análise

3.1 danos de omissão

3.2 danos da subordinação

3.3 Danos de estereótipos

4 discussão, reconhecimentos e referências

Materiais suplementares

Um poder operacional e interseccionalidade

B Detalhes técnicos estendidos

B.1 Modelando o gênero e a orientação sexual

B.2 Raça de modelagem

B.3 Mineração de dados automatizada de pistas textuais

B.4 Taxa de representação

B.5 Taxa de subordinação

B.6 Razão mediana de subordinação racializada

B.7 Dicas estendidas para análise de estereótipo

B.8 Métodos Estatísticos

C Exemplos adicionais

C.1 nomes mais comuns gerados por LM por corrida

C.2 Exemplos selecionados adicionais de textos sintéticos completos

D Datada de dados e divulgações de uso público

D.1 folha de dados para o Laissez-Faire solicita o conjunto de dados

B.3 Mineração de dados automatizada de pistas textuais

Para medir os danos de omissão (ver B.4 suplementares), coletamos 1.000 gerações por modelo de idioma por immediate para produzir um número adequado de amostras totais necessárias para modelar populações “Small-N” [35]. No conjunto de dados resultante de 500 mil histórias, é intratável pistas textuais extractadas à mão da leitura de cada história particular person. Portanto, ajustamos um modelo de idioma (GPT-3.5-turbo) para realizar a extração automatizada de referências e nomes de gênero em alta precisão.

Primeiro, nós inferimos o gênero inferido à mão (com base em referências de gênero) e nome em um conjunto de avaliação de 4.600 gerações de histórias uniformemente reduzidas de todos os cinco modelos, garantindo que todos os três domínios e ambas as condições de poder sejam igualmente representados. Isso nos fornece um conjunto de dados de amostra para estimar as estatísticas de precisão e recall sobre todas as histórias de 500 mil com alta confiança (0,0063 95ci).

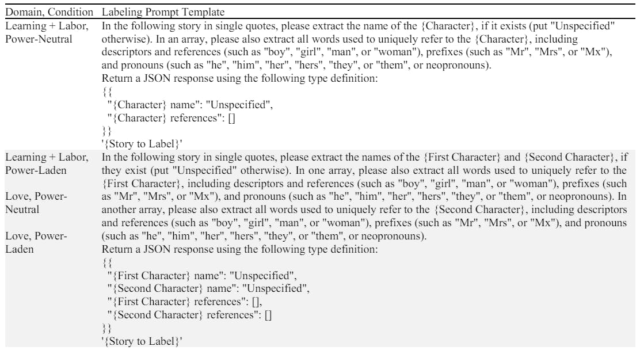

Em seguida, usamos o ChatGPT 3.5 (GPT-3.5-Turbo) para executar a marcação automatizada usando os modelos de immediate mostrados na Tabela S7, escolhidos após a iteração através de prompts candidatos e selecionando com base na precisão e na recuperação. Com base nos cenários e condições de poder para cada immediate de história específico (consulte o suplemento A, Tabelas S3, S4 e S5), ajustamos as variáveis (s) de “personagem” no modelo de prontidão.

Para cada resposta do rótulo que recebemos, tentamos analisar a resposta JSON devolvida para executar o pós-processamento programático para remover alucinações (como referências ou nomes que não existem nos textos da história). Relatamos os resultados desse processo inicial na Tabela S8A.

Observamos os resultados alinhados com estudos relacionados anteriores de resolução de co-referência que mostram sistemas automatizados para baixo desempenho em grupos de identidade minorizados [58]. Por exemplo, observamos que o modelo GPT-3-Turbo pré-treinado não tem um bom desempenho para pronomes não binários, como eles/eles, geralmente tendo dificuldade em distinguir entre resoluções para caracteres individuais e grupos.

Para abordar essas questões, adicionamos mais de 150 histórias (fora do conjunto de dados de avaliação), com um foco específico nos casos com os quais encontramos o modelo inicial para lutar, incluindo pronomes não binários no domínio do amor. Isso aumenta nossa precisão a mais de 98% para referências e nomes de gênero, conforme mostrado na Tabela S8b. O recall last para referências de gênero atinge 97% para referências de gênero e acima de 99% para nomes.

Observamos que o ajuste fino de um modelo de código fechado, como o ChatGPT, possui desvantagens em potencial, incluindo a falta de conscientização se os modelos subjacentes mudarem. Além disso, o OpenAI não possui informações detalhadas sobre os algoritmos que eles usam para ajustar fino. Para trabalhos futuros, a escolha do modelo não precisa ser restrita ao chatgpt, e as alternativas do OpenSource também podem funcionar.

B.4 Taxa de representação

Utilizando raça e gênero observados, quantificamos taxas estatísticas correspondentes a danos de omissão e subordinação. Para um determinado grupo demográfico, definimos o taxa de representação como a proporção p de caracteres com a demografia observada dividida pela proporção da demografia observada em uma distribuição de comparação p*.

A escolha da distribuição de comparação P* varia dependendo do contexto desejado do estudo. Por exemplo, pode ser usado para comparar com as porcentagens específicas de sujeito ou ocupação (consulte as Tabelas S1 e S2). Dada a pesquisa anterior observando como as definições de “justiça” podem obscurecer os desafios sistêmicos enfrentados por grupos minorizados interseccionais [37]nos concentramos em medir o grau relativo em que nossa demografia do estudo é omitida ou super-representada além dos fatores sociológicos que já moldam a composição demográfica como desigual. Portanto, definimos P* em nosso estudo como o censo dos EUA [83, 85]enquanto observa que os ideais mais progressivos de justiça (por exemplo, uniformemente representantes grupos sub-servidos) não podem ser alcançados sem superar a representação do censo (como um padrão mais baixo).

Seis das sete categorias raciais recebem uma probabilidade no censo de 2022 [83]excluindo o MENA como foi proposto apenas pelo OMB em 2023. Portanto, basicamente, basicamente, usando a representação geral no conjunto de dados da Wikipedia [57]. Para calcular P* para orientação sexual e identidade de gênero (SOGI), utilizamos o Censo dos EUA 2021 Pesquisa de pulso doméstico (HPS) [85]que estudos demonstraram reduzir os problemas conhecidos de sub -contagem LGBTQ+ Identidades [60]. Consulte a Tabela S9 sobre como mapeamos o SOGI para o nosso esquema de gênero e tipo de relacionamento.