¿Quieres concepts más inteligentes en tu bandeja de entrada? Regístrese en nuestros boletines semanales para obtener solo lo que importa a los líderes de IA, datos y seguridad empresariales. Suscríbete ahora

Un completo nuevo estudio ha revelado que los modelos de inteligencia synthetic de código abierto consumen significativamente más recursos informáticos que sus competidores de código cerrado al realizar tareas idénticas, potencialmente socavando sus ventajas de costos y remodelando cómo las empresas evalúan las estrategias de implementación de IA.

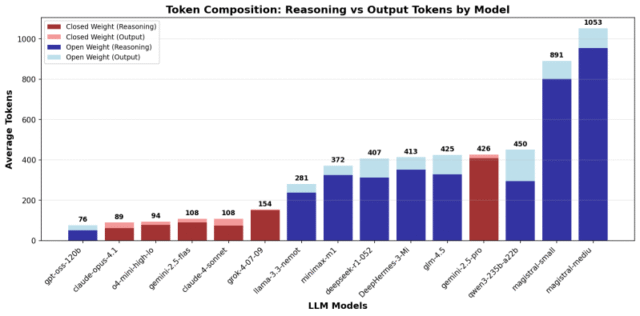

La investigación, realizada por la firma de IA Nous investigacióndescubrió que los modelos de peso abierto usan entre 1.5 y 4 veces más tokens, las unidades básicas del cálculo de IA, que los modelos cerrados como los de Opadai y Antrópico. Para preguntas de conocimiento easy, la brecha se amplió drásticamente, con algunos modelos abiertos que usan hasta 10 veces más tokens.

Medición de la eficiencia del pensamiento en modelos de razonamiento: el punto de referencia que faltahttps://t.co/b1e1rjx6vz

Medimos el uso del token en los modelos de razonamiento: los modelos abiertos emiten 1.5-4x más tokens que los modelos cerrados en tareas idénticas, pero con una gran varianza dependiendo del tipo de tarea (hasta … pic.twitter.com/ly1083won8

– Nous Analysis (@nousResearch) 14 de agosto de 2025

«Los modelos de peso abierto usan 1.5–4 × más tokens que los cerrados (hasta 10 × para preguntas de conocimiento simples), lo que los hace a veces más caros por consulta a pesar de los costos más bajos por contenido», escribieron los investigadores en su informe publicado el miércoles.

Los hallazgos desafían una suposición predominante en la industria de la IA de que los modelos de código abierto ofrecen ventajas económicas claras sobre las alternativas propietarias. Si bien los modelos de código abierto generalmente cuestan menos por token para ejecutarse, el estudio sugiere que esta ventaja puede ser «fácilmente compensada si requieren más tokens para razonar sobre un problema determinado».

AI Scaling alcanza sus límites

Los límites de potencia, el aumento de los costos del token y los retrasos de inferencia están remodelando Enterprise AI. Únase a nuestro salón exclusivo para descubrir cómo son los mejores equipos:

- Convertir la energía en una ventaja estratégica

- Arquitectura de inferencia eficiente para ganancias reales de rendimiento

- Desbloquear ROI competitivo con sistemas de IA sostenibles

Asegure su lugar para mantenerse a la vanguardia:

El costo actual de la IA: por qué los modelos ‘más baratos’ pueden romper su presupuesto

La investigación examinada 19 modelos de IA diferentes En tres categorías de tareas: preguntas de conocimiento básico, problemas matemáticos y rompecabezas lógicos. El equipo midió la «eficiencia de tokens», cuántos modelos de unidades computacionales usan en relación con la complejidad de sus soluciones, una métrica que ha recibido poco estudio sistemático a pesar de sus importantes implicaciones de costos.

«La eficiencia del token es una métrica crítica por varias razones prácticas», señalaron los investigadores. «Si bien el alojamiento de modelos de peso abierto puede ser más barato, esta ventaja de costo podría compensarse fácilmente si requieren más tokens para razonar sobre un problema determinado».

La ineficiencia es particularmente pronunciada para grandes modelos de razonamiento (LRMS), que usan extendido «cadenas de pensamiento«Para resolver problemas complejos. Estos modelos, diseñados para pensar a través de los problemas paso a paso, pueden consumir miles de tokens que reflexionan sobre preguntas simples que deberían requerir un cálculo mínimo.

Para preguntas de conocimiento básico como «¿Cuál es la capital de Australia?» El estudio encontró que los modelos de razonamiento gastan «cientos de tokens que reflexionan sobre preguntas simples de conocimiento» que podrían responderse en una sola palabra.

Que los modelos de IA realmente ofrecen su billete por tu dinero

La investigación reveló marcadas diferencias entre los proveedores de modelos. Modelos de Openai, particularmente su O4-Mini y recién lanzado de código abierto gt-oss Variantes, demostradas con una eficiencia de token excepcional, especialmente para problemas matemáticos. El estudio encontró que los modelos Operai «destacan la eficiencia de token extrema en los problemas matemáticos», utilizando hasta tres veces menos tokens que otros modelos comerciales.

Entre las opciones de código abierto, Nvidia’s Llama-3.3-Nemotron-Super-49B-V1 surgió como «el modelo de peso abierto más eficiente de token en todos los dominios», mientras que los modelos más nuevos de compañías como Mistral mostraron «uso de token excepcionalmente alto» como valores atípicos.

La brecha de eficiencia varió significativamente según el tipo de tarea. Si bien los modelos abiertos usaron aproximadamente el doble de tokens para problemas matemáticos y lógicos, la diferencia se disparó para preguntas de conocimiento simples donde el razonamiento eficiente debe ser innecesario.

Lo que los líderes empresariales necesitan saber sobre los costos informáticos de la IA

Los hallazgos tienen implicaciones inmediatas para la adopción de IA empresarial, donde los costos informáticos pueden escalar rápidamente con el uso. Las empresas que evalúan los modelos de IA a menudo se centran en puntos de referencia de precisión y precios por juicio, pero pueden pasar por alto los requisitos computacionales totales para las tareas del mundo actual.

«La mejor eficiencia del token de los modelos de peso cerrado a menudo compensa el mayor precio de API de esos modelos», encontraron los investigadores al analizar los costos de inferencia whole.

El estudio también reveló que los proveedores de modelos de código cerrado parecen optimizar activamente para la eficiencia. «Los modelos de peso cerrado se han optimizado iterativamente para usar menos tokens para reducir el costo de inferencia», mientras que los modelos de código abierto han «aumentado su uso de tokens para versiones más nuevas, posiblemente reflejando una prioridad hacia un mejor rendimiento de razonamiento».

Cómo los investigadores descifraron el código en la medición de eficiencia de IA

El equipo de investigación enfrentó desafíos únicos para medir la eficiencia en diferentes arquitecturas de modelos. Muchos modelos de código cerrado no revelan sus procesos de razonamiento sin procesar, sino que proporcionan resúmenes comprimidos de sus cálculos internos para evitar que los competidores copien sus técnicas.

Para abordar esto, los investigadores utilizaron tokens de finalización, las unidades computacionales totales facturadas para cada consulta, como un proxy para el esfuerzo de razonamiento. Descubrieron que «los modelos de código cerrado más reciente no compartirán sus trazas de razonamiento en bruto» y, en su lugar, «use modelos de lenguaje más pequeños para transcribir la cadena de pensamiento en resúmenes o representaciones comprimidas».

La metodología del estudio incluyó pruebas con versiones modificadas de problemas bien conocidos para minimizar la influencia de soluciones memorizadas, como la alteración de las variables en problemas de competencia matemática de los Examen de matemáticas de Invitational American (AIME).

El futuro de la eficiencia de la IA: lo que viene después

Los investigadores sugieren que la eficiencia del token debería convertirse en un objetivo de optimización primario junto con la precisión para el desarrollo futuro del modelo. «Una cuna más densificada también permitirá un uso de contexto más eficiente y puede contrarrestar la degradación del contexto durante las tareas de razonamiento desafiantes». ellos escribieron.

El lanzamiento de la fuente abierta de OpenAi modelos GPT-ossque demuestra la eficiencia de vanguardia con «cuna accesible libremente», podría servir como un punto de referencia para optimizar otros modelos de código abierto.

El conjunto de datos de investigación y el código de evaluación Disponible en Githubpermitiendo a otros investigadores validar y extender los hallazgos. A medida que la industria de la IA corre hacia capacidades de razonamiento más poderosas, este estudio sugiere que la verdadera competencia puede no ser sobre quién puede construir la IA más inteligente, pero quién puede construir la más eficiente.

Después de todo, en un mundo donde cada ficha cuenta, los modelos más derrochadores pueden encontrarse con un precio fuera del mercado, independientemente de qué tan bien puedan pensar.

avots