Tabela de links

Resumo e 1. Introdução

2 conceitos em dados de pré -treinamento e frequência de quantificação

3 Comparando a frequência de pré-treinamento e o desempenho “zero tiro” e a configuração experimental 3.1

3.2 Resultado: A frequência de pré-treinamento é preditiva de desempenho “zero tiro”

4 Testes de estresse A tendência de escala de desempenho de frequência conceitual e 4.1 controlando amostras semelhantes em dados pré-treinamento e a jusante

4.2 Generalização de teste para conceito puramente sintético e distribuições de dados

5 idéias adicionais de frequências de conceito de pré -treinamento

6 Testando a cauda: Deixe -a abanar!

7 Trabalho relacionado

8 Conclusões e problemas abertos, reconhecimentos e referências

Parte I.

Apêndice

A. A frequência do conceito é preditiva de desempenho em estratégias de promoção

B. A frequência do conceito é preditiva de desempenho nas métricas de recuperação

C. A frequência conceitual é preditiva de desempenho para modelos T2i

D. A frequência do conceito é preditiva de desempenho entre conceitos apenas de domínios de imagem e texto

E. Detalhes experimentais

F. Por que e como usamos o RAM ++?

G. Detalhes sobre resultados de grau de desalinhamento

Modelos H. T2i: Avaliação

I. Resultados da classificação: deixe -o abanar!

3 Comparando a frequência de pré-treinamento e o desempenho “zero tiro”

Tendo obtido estimativas de frequência para nossos conceitos a jusante, estabelecemos agora a relação entre frequências de conceito de pré-treinamento de texto de imagem e desempenho de tiro zero nas tarefas de classificação, recuperação e geração. Primeiro detalhamos nossa abordagem experimental e depois discutimos os principais resultados.

3.1 Configuração experimental

Analisamos duas classes de modelos multimodais: texto de imagem e texto a imagem. Para ambos, detalhamos os conjuntos de dados de pré -treinamento e teste, juntamente com seus parâmetros de avaliação associados.

3.1.1 modelos de texto de imagem (clipe)

Conjuntos de dados. Nossa avaliação consiste em 4 conjuntos de dados de pré -treinamento, 2 conjuntos de dados de recuperação a jusante e 17 conjuntos de dados de classificação a jusante, apresentados na guia. 1, cobrindo um amplo espectro de objetos, cenas e distinções de granulação fina.

Modelos. Testamos o clipe [91] Modelos com ambos o resnet [53] e transformador de visão [36] Arquitetura, com Vit-B-16 [81] e RN50 [48, 82] Treinado em CC-3M e CC-12M, Vit-B-16, RN50 e RN101 [61] Treinado em YFCC-15M e Vit-B-16, Vit-B-32 e Vit-L-14 treinado em Laion400m [102]. Seguimos o clipe aberto [61]escorregar [81] e ciclip [48] Para todos os detalhes da implementação.

Solicitando. Para classificação zero-tiro, experimentamos três estratégias de estimulação: {ClassName} somente, “uma foto de um {className}” e o prompt-sensores [91]que calcula a média de mais de 80 variações de prompt diferentes {ClassName}. Para recuperação, usamos a imagem ou a legenda como entrada correspondente à recuperação I2T (imagem para texto) ou T2i (texto a imagem), respectivamente.

Métricas. Calculamos a precisão média da classificação de tiro zero para tarefas de classificação [91]. Para recuperação, avaliamos o desempenho usando métricas tradicionais para tarefas de recuperação de texto para imagem e imagem para texto [91] (Lembre -se@1, lembre -se de 5, lembre -se de 10).

3.1.2 Modelos de texto para imagem

Conjuntos de dados. Nosso conjunto de dados de pré-treinamento é Laion-Aesthetics [103]com avaliações a jusante feitas em versões subamostradas de oito conjuntos de dados, conforme liberado por Heim [71]: Cub200 [121]Daily-Dalle [33]Assim,

Detecção [30]Parti-PROMPTS [130]Drawbench [98]Coco-Base [73]Entendimento relacional [32] e WinogRound [114]. Por favor, consulte Heim [71] Para mais detalhes sobre os conjuntos de dados de avaliação usados.

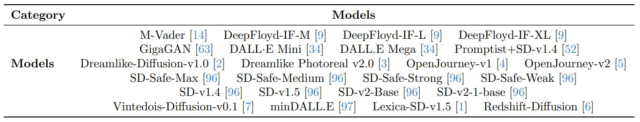

Modelos. Avaliamos 24 modelos T2i, detalhados na guia. 2. Seus tamanhos variam de 0,4b parâmetros (Deepfloyd-if-M [9] e Dall · E mini [34]) para 4,3b parâmetros (Deepfloyd-if-xl [9]). Incluímos vários modelos de difusão estável [96] bem como variantes sintonizadas para estilos visuais específicos [6, 4, 5].

Solicitando. Os avisos de texto dos conjuntos de dados de avaliação são usados diretamente para gerar imagens, com 4 amostras de imagem geradas para cada prompt.

Métricas. A avaliação consiste em alinhamento de texto de imagem e escores estéticos. Para métricas automatizadas [71]usamos o escore esperado e max [57] Para medir o alinhamento de texto de imagem, juntamente com o esperado e o max estético-escore [102] para medir a estética. Para verificar a confiabilidade das métricas automatizadas, comparamos-as com as pontuações classificadas pelo ser humano (medidas em uma escala de classificação de 5 pontos) para o alinhamento de texto de imagem e estética [71]. Para complementar as pontuações classificadas pelo ser humano fornecidas pelo Heim [71]Confirmamos nossas descobertas, realizando uma avaliação humana em pequena escala (ver Appx. C).

3.2 Resultado: A frequência de pré-treinamento é preditiva de desempenho “zero tiro”

Agora investigamos o impacto da frequência do conceito nos conjuntos de dados pré-treinamento no desempenho de tiro zero dos modelos de texto de imagem. Utilizamos as frequências de conceito de texto de imagem correspondentes para estimar a frequência de conceitos durante o pré-treinamento. Nossas descobertas, ilustradas de maneira abrangente nas Figs. 2 e 3, demonstrem que a frequência do conceito de efeito tem sobre o desempenho do modelo em várias tarefas e tipos de modelos.

Compreendendo as parcelas. Os gráficos no papel principal apresentam resultados de classificação de imagem de imagem de texto (CLIP), usando a precisão e o desempenho da recuperação de texto em imagem usando o RECALM@10. Da mesma forma, apresentamos o desempenho dos modelos generativos T2I nas tarefas de geração de imagens usando a pontuação de estética esperada. Para outras métricas mencionadas acima para recuperar, bem como outras métricas de geração automatizada, juntamente com as pontuações classificadas pelo ser humano, descobrimos que elas mostram tendências semelhantes e as fornecemos para referência em aplicativos. B e C. Para maior clareza, a apresentação dos dados é simplificada de gráficos de dispersão para uma linha coesa semelhante ao trabalho de Kandpal et al. [62] e Razeghi et al. [94]. O eixo x é escala de log e as métricas de desempenho são calculadas em caixas em caixas ao longo deste eixo para facilitar a visualização da correlação log-linear. Removemos caixotes contendo muito poucos conceitos por compartimento por remoção padrão de IQR [122] Seguindo Kandpal et al. [62]. Além disso, calculamos a correlação de Pearson ρ para cada linha e fornecemos resultados de significância com base em um teste t bicaudal [110].

Chave Acocando: Escala Log-Linear entre a frequência do conceito e o desempenho de tiro zero. Em todas as 16 parcelas, observamos uma relação log-linear clara entre a frequência do conceito e o desempenho de tiro zero. Note that these plots vary in (i) discriminative vs. generative model types, (ii) classification vs. retrieval tasks, (iii) model architecture and parameter scales, (iv) pretraining datasets with different curation methods and scales, (v) different evaluation metrics, (vi) different prompting strategies for zero-shot classification, and (vii) concept frequencies isolated only from image or text domains (additional experiments que mostram variações ao longo (V) são apresentadas nos aplicativos. A tendência de escala log-linear observada persiste nas sete dimensões apresentadas. Assim, nossos resultados revelam claramente o aprendizado faminto de dados, ou seja, a falta da capacidade dos modelos multimodais atuais de aprender conceitos com conjuntos de dados pré-treinos de maneira eficiente em termos de amostra.

Autores:

(1) Vishaal Udandarao, Tubingen AI Center, Universidade de Tubingen, Universidade de Cambridge e contribuição igual;

(2) Ameya Prabhu, Tubingen AI Center, Universidade de Tubingen, Universidade de Oxford e Igualista;

(3) Adhiraj Ghosh, Tubingen AI Center, Universidade de Tubingen;

(4) Yash Sharma, Tubingen AI Center, Universidade de Tubingen;

(5) Philip HS Torr, Universidade de Oxford;

(6) Adel Bibi, Universidade de Oxford;

(7) Samuel Albanie, Universidade de Cambridge e Aconselhamento Igual, Ordem decidida por um flip de moedas;

(8) Matthias Bethge, Tubingen AI Center, Universidade de Tubingen e Aconselhamento Igual, Ordem decidida por uma moeda.