Tabela de links

Resumo e 1 Introdução

2 trabalhos relacionados

3 Modelo e 3.1 Memórias Associativas

3.2 blocos de transformadores

4 Uma nova função energética

4.1 A estrutura em camadas

5 Perda de entropia cruzada

6 Resultados empíricos e 6.1 Avaliação empírica do raio

6.2 Treinamento GPT-2

6.3 Treinando transformadores de baunilha

7 Conclusão e Agradecimentos

Apêndice A. Tabelas diferidas

Apêndice B. Algumas propriedades das funções energéticas

Apêndice C. As provas diferidas da Seção 5

Apêndice D. Detalhes do transformador: Usando o GPT-2 como exemplo

Referências

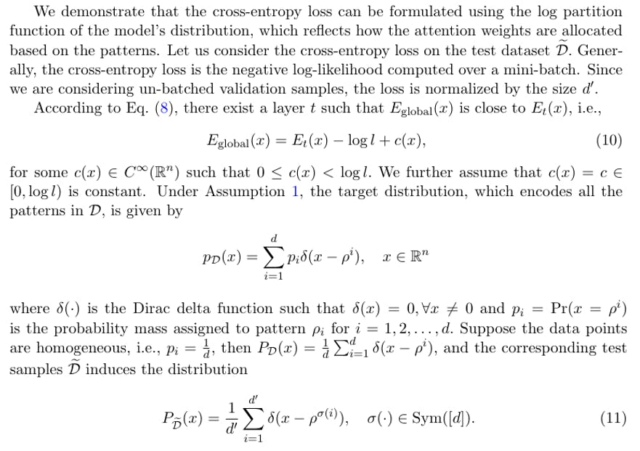

5 Perda de entropia cruzada

Agora passamos a analisar a perda de redes de transformadores. A perda de entropia cruzada, que mede a diferença entre as probabilidades previstas e os rótulos reais, é comumente usada para o treinamento de modelos de transformadores. O mecanismo de atenção inclui uma operação softmax que gera uma distribuição de probabilidade p ∈ ∆n. Na prática, a saída final do softmax é então alimentada em uma camada específica da tarefa para tarefas a jusante, como previsões e classificações. Assim, comparamos a última saída Softmax dos blocos de transformadores com a distribuição de destino.

Temos o seguinte resultado em relação à perda de entropia cruzada.

Observação 2 A entropia cruzada pode ser escrita como

Quando o modelo é gravemente super parametricado, a função de energia pode muito bem se aproximar da energia da distribuição da amostra. Nesse caso, a entropia cruzada mínima é igual à entropia das amostras de treinamento.

Em seguida, examinamos mais de perto a função de partição da camada. Nós temos

Na Tabela 2 no Apêndice A, comparamos a perda de entropia cruzada relatada de vários modelos baseados em transformadores na literatura. Geralmente, é relatada uma família de modelos que varia em vários tamanhos e selecionamos os maiores. Observamos que a perda de entropia cruzada semelhante é alcançada em uma ampla gama de formas arquitetônicas (incluindo profundidade, largura, cabeças de atenção, dimensões FF e comprimentos de contexto). No entanto, todas as perdas satisfazem l> 1.

Observação 3 Observamos que alguns modelos adicionam termos de regularização auxiliar, como a perda Z (Chowdhery et al., 2023; Yang et al., 2023) durante o treinamento. Nesses casos, as leis de escala devem levar em consideração os termos adicionais. Além disso, modificações nos blocos de transformadores, como normalização adicional da camada, podem contribuir para o limite inferior da entropia cruzada.