Assim que o ChatGPT se tornou amplamente disponível, surpreendeu o mundo com sua capacidade de responder a perguntas na linguagem pure quase imediatamente. Ainda faz isso hoje, e seu desempenho melhorou significativamente também.

No entanto, os usuários descobriram rapidamente que chatbots como o ChatGPT nem sempre fornecem informações precisas. Eles convincentemente alucinam. É por isso que tenho avisado sobre as alucinações da IA desde os primeiros dias do ChatGPT e rotineiramente lembrando que você solicita fontes e verifique os fatos que o chatbot vomita.

O Chatgpt e seus rivais percorreram um longo caminho desde então. O Openai e outras empresas de IA fornecerão fontes para as reivindicações que a IA faz, especialmente quando uma pesquisa na Web está envolvida. Apesar dessas atualizações, ainda tenho instruções personalizadas dizendo à IA para me dar hyperlinks claros e de trabalho para tudo o que diz. Ainda corrijo a IA quando diz algo incorreto.

As alucinações provavelmente desaparecerão em chatbots de IA mais avançados no futuro não muito distante. Mas pode demorar um pouco para chegar lá. Chatgpt O3 e O4-mini são a melhor prova disso. Eles são os modelos de raciocínio mais avançados do ChatGPT, excedendo o desempenho do ChatGPT O1 em vários campos.

Estranhamente, no entanto, o Chatgpt O3 e O4-mini estão alucinando mais do que seus antecessores, e isso é algo que o OpenAi admitiu por conta própria. Não está claro o que causa esse comportamento.

OpenAI detalhou as estatísticas de alucinação para O3 e O4-mini no Arquivo do cartão do sistema Para os novos modelos. Portanto, não é de admirar que você verá muitos usuários de chatgpt menção esse comportamento incomum.

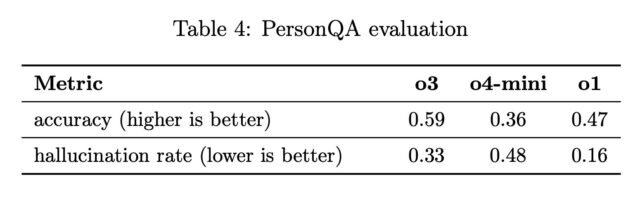

“Testamos o OpenAI O3 e O4-Mini contra o Personqa, uma avaliação que visa provocar alucinações. Personqa é um conjunto de dados de perguntas e fatos disponíveis ao público que mede a precisão do modelo nas tentativas de respostas”. Openai escreve. “Consideramos duas métricas: precisão (o modelo respondeu à pergunta corretamente) e taxa de alucinação (verificando a frequência com que o modelo alucinou)”.

“O modelo de O4-mini tem um desempenho inferior a O1 e O3 em nossa avaliação do PersonQA. Isso é esperado, pois os modelos menores têm menos conhecimento mundial e tendem a alucinar mais. No entanto, também observamos algumas diferenças de desempenho comparando O1 e O3. Especificamente, o que é necessário.

A equipe do Openai também publicou a tabela acima, que mostra que o ChatGPT O3 é mais preciso que o O1, mas alucinará o dobro da taxa de O1. Quanto ao O4-mini, o modelo menor produzirá respostas menos precisas que o O1 e O3 e alucinará três vezes a taxa de O1.

É fascinante que o OpenAI tenha treinado modelos de raciocínio mais avançados que podem usar a pesquisa na Web enquanto raciocinam e incorporam imagens em sua cadeia de pensamento, mas a empresa não pode explicar por que as taxas de alucinação aumentaram.

Esses modelos de IA de raciocínio podem fazer coisas incríveis, como uma análise profunda de imagens que permitem determinar onde uma foto foi tirada olhando para ela. Eles podem navegar completamente na net para obter suas informações. No entanto, eles inventarão coisas ao longo do caminho. Eles não podem se impedir de inventar fatos. O Openai não encontrou a receita de treinamento para que isso aconteça.

Não posso dizer que encontrei muitas alucinações O3 e O4-Mini, mas eu vi o último saltando para pelo menos uma conclusão mais rapidamente do que deveria. Provavelmente, as informações alucinadas no processo. Tudo o que sei é que vou continuar verificando as reivindicações da IA para o futuro próximo, independentemente dos modelos que eu corro.