Tabela de links

Resumo e 1. Introdução

2 conceitos em dados de pré -treinamento e frequência de quantificação

3 Comparando a frequência de pré-treinamento e o desempenho “zero tiro” e a configuração experimental 3.1

3.2 Resultado: A frequência de pré-treinamento é preditiva de desempenho “zero tiro”

4 Testes de estresse A tendência de escala de desempenho de frequência conceitual e 4.1 controlando amostras semelhantes em dados pré-treinamento e a jusante

4.2 Generalização de teste para conceito puramente sintético e distribuições de dados

5 idéias adicionais de frequências de conceito de pré -treinamento

6 Testando a cauda: Deixe -a abanar!

7 Trabalho relacionado

8 Conclusões e problemas abertos, reconhecimentos e referências

Parte I.

Apêndice

A. A frequência do conceito é preditiva de desempenho em estratégias de promoção

B. A frequência do conceito é preditiva de desempenho nas métricas de recuperação

C. A frequência conceitual é preditiva de desempenho para modelos T2i

D. A frequência do conceito é preditiva de desempenho entre conceitos apenas de domínios de imagem e texto

E. Detalhes experimentais

F. Por que e como usamos o RAM ++?

G. Detalhes sobre resultados de grau de desalinhamento

Modelos H. T2i: Avaliação

I. Resultados da classificação: deixe -o abanar!

6 Testando a cauda: Deixe -o abanar!

Motivação. Nas seções anteriores, identificamos uma distribuição conceitual consistente de cauda longa, destacando a escassez de certos conceitos na web. Essa observação forma a base de nossa hipótese de que os modelos provavelmente tenham um desempenho inferior quando testados em relação às distribuições de dados que são fortemente de cauda longa. Para testar isso, selecionamos cuidadosamente 290 conceitos que foram identificados como os menos frequentes em todos os conjuntos de dados pré -treinando. Isso inclui conceitos como uma aeronave A310, um wormnake e um rei tropical. Em seguida, usamos esses conceitos para criar um conjunto de testes de classificação, “Deixe abanar!”.

Detalhes do conjunto de dados. O “Deixe abanar!” O conjunto de dados de classificação compreende 130k amostras de teste baixadas da web usando o método de Prabhu et al. [90]. As amostras de teste são distribuídas uniformemente em 290 categorias que representam conceitos de cauda longa. A partir da lista de conceitos com curadoria, baixamos imagens de conjunto de testes, deduzemos-as, removemos outliers e, finalmente, limpamos manualmente e verificamos as etiquetas.

Detalhes da análise. Executamos experimentos de classificação e geração de imagens em “Deixe abanar!”. Para classificação, avaliamos o desempenho de 40 modelos de imagem de texto (CLIP) no “Deixe abanar!” conjunto de dados de classificação, usando um conjunto de 80 instruções de Radford et al. [91]. Para a tarefa generativa, utilizamos SD-XL [89] Sd-v2 [96]e Dream-Fotoreal-V2.0 [3] Para gerar imagens para os conceitos de cauda longa. Para cada modelo, executamos 50 etapas de difusão, mantendo as configurações padrão para todos os outros parâmetros.

Resultados da classificação de imagem de texto. Mostramos os resultados de nossa tarefa de classificação de cauda longa na Fig. 6-Plote os resultados de todos os modelos em ambos “Deixe abanar!” (eixo y) e imagenet (eixo x). Observamos que todos os modelos têm desempenho inferior por grandes margens na cauda de longa “Deixe abanar!” DataSet (até 20% mais baixas precisão absoluta em comparação com o ImageNet). Essa queda de desempenho generaliza em todas as escalas de modelo e 10 diferentes distribuições de dados de pré-treinamento, reforçando a noção de que todos os conjuntos de dados de pré-treinamento de origem na Web são inerentemente restringidos a serem de cauda longa. Com isso dito, observe que os modelos de maior capacidade (linha ajustada com inclinação = 1,58 na Fig. 6) parecem estar fechando a diferença para o desempenho do ImageNet, indicando melhor desempenho nos conceitos de cauda de longa duração.

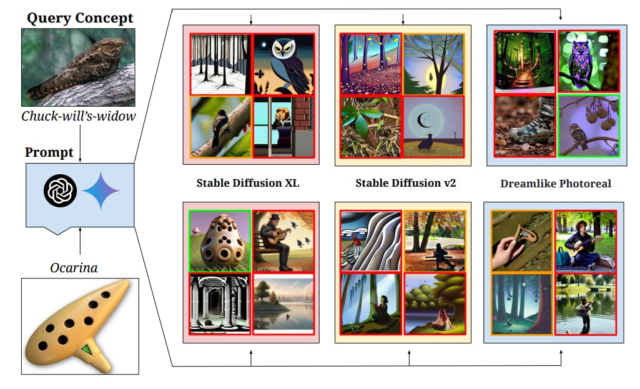

Resultados da geração T2I. Fornecemos uma análise qualitativa sobre a geração de imagens para avaliar os modelos T2I em conceitos raros na Fig. 7. Para diversidade, geramos prompts usando Gemini [112] (linha superior de imagens geradas) e GPT4 [12] (linha inferior de imagens geradas). As fronteiras verdes representam gerações corretas, as fronteiras vermelhas representam gerações incorretas e as fronteiras amarelas representam geração ambígua. Embora o solicitação descritivo geralmente ajude a melhorar a qualidade das imagens geradas [52]ainda observamos modelos T2i que não conseguem compreender e representam com precisão muitos conceitos em nosso “Deixe abanar!” conjunto de dados. Alguns casos de falha envolvem atividades de deturpamento (como pizzas ou boliche de críquete, como mostrado na Fig. 24), gerando o conceito errado (Widow de Chuck-Will, como mostrado na Fig. 7, além de não compreender o conceito (Ocarina na Fig. 7 inferior). Podemos ver que os modelos de difusão estáveis são propensos à cauda longa qualitativamente – também fornecemos resultados quantitativos no APPX. H.1.

Conclusão. Nos experimentos de classificação e geração, mostramos que os modelos multimodais atuais previsivelmente tiveram desempenho inferior, independentemente de sua escala de modelo ou conjuntos de dados de pré -treinamento. Isso sugere a necessidade de melhores estratégias para o aprendizado com eficiência de amostra em cauda longa.

Autores:

(1) Vishaal Udandarao, Tubingen AI Center, Universidade de Tubingen, Universidade de Cambridge e contribuição igual;

(2) Ameya Prabhu, Tubingen AI Center, Universidade de Tubingen, Universidade de Oxford e Igualista;

(3) Adhiraj Ghosh, Tubingen AI Center, Universidade de Tubingen;

(4) Yash Sharma, Tubingen AI Center, Universidade de Tubingen;

(5) Philip HS Torr, Universidade de Oxford;

(6) Adel Bibi, Universidade de Oxford;

(7) Samuel Albanie, Universidade de Cambridge e Aconselhamento Igual, Ordem decidida por um flip de moedas;

(8) Matthias Bethge, Tubingen AI Center, Universidade de Tubingen e Aconselhamento Igual, Ordem decidida por uma moeda.

![Figura 7: Resultados qualitativos no “Let It Wag!” As categorias de dados demonstram casos de falha de modelos de T2I de última geração em conceitos de cauda longa. Em nossos experimentos, criamos 4 prompts de texto para cada categoria usando gêmeos [112] e GPT4 [12] que são alimentados a 3 difusão estável [96] modelos. A geração com borda vermelha está incorreta, com a borda verde está correta e com borda amarela é ambígua. Observamos que, apesar dos avanços na geração de imagens de alta fidelidade, há margem para melhorar esses conceitos.](https://hackernoon.imgix.net/images/fWZa4tUiBGemnqQfBGgCPf9594N2-sh832c5.png?auto=format&fit=max&w=3840)