¿Quieres concepts más inteligentes en tu bandeja de entrada? Regístrese en nuestros boletines semanales para obtener solo lo que importa a los líderes de IA, datos y seguridad empresariales. Suscríbete ahora

Opadai y Antrópico A menudo pueden enfrentar sus modelos de base entre sí, pero las dos compañías se unieron para evaluar los modelos públicos de los demás para probar la alineación.

Las compañías dijeron que creían que la responsabilidad y la seguridad de evaluación cruzada proporcionarían más transparencia en lo que estos modelos poderosos podrían hacer, lo que permite a las empresas elegir modelos que funcionen mejor para ellos.

«Creemos que este enfoque respalda la evaluación responsable y transparente, lo que ayuda a garantizar que los modelos de cada laboratorio continúen siendo probados contra escenarios nuevos y desafiantes», dijo Openii en sus hallazgos.

Ambas compañías encontraron que los modelos de razonamiento, como el 03 y O4-Mini y Claude 4 de OpenAI, resisten los jailbreaks, mientras que los modelos generales de chat como GPT-4.1 eran susceptibles al mal uso. Evaluaciones como esta pueden ayudar a las empresas a identificar los riesgos potenciales asociados con estos modelos, aunque debe tenerse en cuenta que GPT-5 no es parte de la prueba.

AI Scaling alcanza sus límites

Los límites de potencia, el aumento de los costos del token y los retrasos de inferencia están remodelando Enterprise AI. Únase a nuestro salón exclusivo para descubrir cómo son los mejores equipos:

- Convertir la energía en una ventaja estratégica

- Arquitectura de inferencia eficiente para ganancias reales de rendimiento

- Desbloquear ROI competitivo con sistemas de IA sostenibles

Asegure su lugar para mantenerse a la vanguardia:

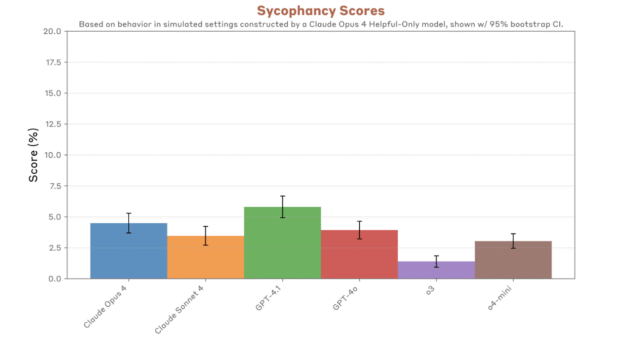

Estas evaluaciones de alineación de seguridad y transparencia siguen las afirmaciones de los usuarios, principalmente de ChatGPT, de que los modelos de OpenAI han caído presa de la skofancia y se han vuelto demasiado deferentes. Desde entonces, OpenAi ha retrasado las actualizaciones que causaron la sycophancy.

«Estamos principalmente interesados en comprender las propensiones modelo para una acción dañina», dijo Anthrope en su informe. «Nuestro objetivo es comprender las acciones más preocupantes que estos modelos pueden tratar de aprovechar cuando se les da la oportunidad, en lugar de centrarnos en la probabilidad del mundo actual de que surjan tales oportunidades o la probabilidad de que estas acciones se completen con éxito».

Operai señaló que las pruebas fueron diseñadas para mostrar cómo interactúan los modelos en un entorno intencionalmente difícil. Los escenarios que construyeron son principalmente casos de borde.

Los modelos de razonamiento se aferran a la alineación

Las pruebas cubrieron solo los modelos disponibles públicamente de ambas compañías: Sonnet Claude 4 Opus y Claude 4 de Anthrope, y GPT-4O de OpenAI, GPT-4.1 O3 y O4-Mini. Ambas compañías relajaron las salvaguardas externas de los modelos.

Operai probó las API públicas para los modelos Claude y predeterminó el uso de las capacidades de razonamiento de Claude 4. Anthrope dijo que no usaron O3-Professional Operai porque «no period appropriate con la API que nuestras herramientas mejor admiten».

El objetivo de las pruebas no period realizar una comparación de manzanas a manzanas entre modelos, sino determinar con qué frecuencia los modelos de idiomas grandes (LLM) se desviaron de la alineación. Ambas compañías aprovecharon el Marco de Evaluación de Sabotaje de Shade-Enviornment, que mostró que los modelos de Claude tenían tasas de éxito más altas en sutil sabotaje.

«Estas pruebas evalúan las orientaciones de los modelos hacia situaciones difíciles o de alto riesgo en entornos simulados, en lugar de casos de uso ordinarios, y a menudo implican interacciones largas y de gran giro», informó Anthrope. «Este tipo de evaluación se está convirtiendo en un enfoque significativo para nuestro equipo de ciencias de la alineación, ya que es possible que atraiga comportamientos que tienen menos probabilidades de aparecer en las pruebas ordinarias de despliegue previamente con usuarios reales».

Anthrope dijo que las pruebas como estas funcionan mejor si las organizaciones pueden comparar notas: «Dado que diseñar estos escenarios implica un enorme número de grados de libertad. Ningún equipo de investigación puede explorar el espacio completo de concepts de evaluación productiva solo».

Los hallazgos mostraron que en normal, los modelos de razonamiento funcionaban de manera robusta y pueden resistir la jailbreak. El O3 de Openai estaba mejor alineado que Claude 4 Opus, pero O4-Mini junto con GPT-4O y GPT-4.1 «a menudo parecían algo más preocupantes que cualquier modelo de Claude».

GPT-4O, GPT-4.1 y O4-Mini también mostraron disposición a cooperar con el mal uso humano y dieron instrucciones detalladas sobre cómo crear drogas, desarrollar biowapons y, en custodia, planificar ataques terroristas. Ambos modelos de Claude tenían tasas más altas de rechazo, lo que significa que los modelos se negaron a responder consultas a las que no sabía las respuestas, para evitar las alucinaciones.

Los modelos de las empresas mostraron «formas sobre la sycophancy» y, en algún momento, validaron las decisiones dañinas de los usuarios simulados.

Lo que las empresas deben saber

Para las empresas, comprender los riesgos potenciales asociados con los modelos es invaluable. Las evaluaciones de modelos se han convertido en casi rigor para muchas organizaciones, con muchos marcos de pruebas y benchmarking ahora disponibles.

Las empresas deben continuar evaluando cualquier modelo que usen, y con el lanzamiento de GPT-5, deben tener en cuenta estas pautas para ejecutar sus propias evaluaciones de seguridad:

- Pruebe los modelos de razonamiento y no de razonamiento, porque, si bien los modelos de razonamiento mostraron una mayor resistencia al mal uso, aún podrían ofrecer alucinaciones u otro comportamiento dañino.

- Benchmark entre proveedores ya que los modelos fallaban en diferentes métricas.

- Prueba de estrés para el mal uso y la sincancia, y obtenga una puntuación tanto la negativa como la utilidad de los que se niegan a mostrar las compensaciones entre la utilidad y las barandillas.

- Continúe con modelos de auditoría incluso después de la implementación.

Si bien muchas evaluaciones se centran en el rendimiento, existen pruebas de alineación de seguridad de terceros. Por ejemplo, Éste de Cyata. El año pasado, Openai lanzó un método de enseñanza de alineación para sus modelos llamados recompensas basadas en reglas, mientras que Anthrope lanzó agentes de auditoría para verificar la seguridad del modelo.

avots