Tabela de links

Resumo e 1. Introdução

- Preliminares

- Métodos

- Experimentos

- Trabalhos relacionados

- Conclusão e referências

- Detalhes de experimentos

- Resultados experimentais adicionais

3 métodos

Nesta seção, decompomos os filtros de convolução sobre um pequeno conjunto de elementos de subespaço de filtro, referidos como átomos de fitler. Esta formulação permite um novo método de ajuste de modelo via subespaço de filtro ajustando apenas átomos de filtro.

3.1 Formulação da decomposição do filtro

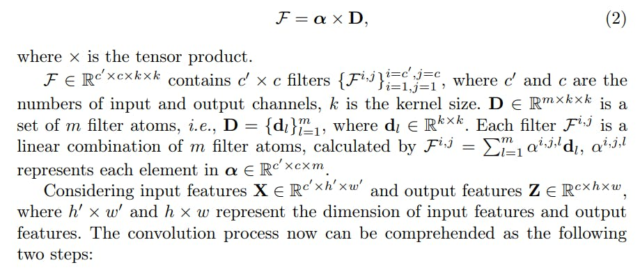

Nossa abordagem envolve a decomposição de cada camada convolucional f em duas camadas convolucionais padrão: uma camada de átomo de filtro d que modela o filtro subespaço[1 , and an atom coefficient layer α with 1 × 1 filters that represent combination rules of filter atoms, as displayed in Figure 2 (a). This formulation is written as

• Spatial-only Convolution with D. Each channel of the input features X convolves with each filter atom separately to produce intermediate features

This process leads to the generation of m distinct intermediate output channels for each input channel, which is illustrated in Figure 2 (b). In this step, filter atoms focus only on handling the spatial information of input features, and cross-channel mixing is postponed to the next step.

• Cross-channel Mixing with α. Subsequently, atom coefficients weigh and linearly combine the intermediate features to produce output features

Z = a x Z’

The spatially invariant channel weights, atom coefficients α, serve as operators for channel mixing, functioning as distinct combination rules that construct the output features from the elemental feature maps generated by the filter atoms. During the model tuning, α is obtained from the pre-trained model and remains unchanged, while only filter atoms D adapt to the target task.

Summary. The two-step convolution operation explains different functionalities of filter atoms D and atom coefficients α, which is, D only contribute to spatial convolution and α only perform cross-channel mixing. In practice, the convolution operation is still performed as one layer, without generating intermediate features, to avoid memory cost. In the fine-tuning process, we solely adjust D, which contains a small set of number of parameters, k × k ≪ c′ × c, thereby facilitating parameter-efficient fine-tuning.

3.2 Overcomplete Filter Atoms

The parameters of filter atoms are extremely small compared with overall model parameters. For instance, the filter atoms constitute a mere 0.004% of the total parameters in ResNet50 [13]. Para explorar totalmente o potencial do ajuste do subespaço de filtro, mostramos a próxima maneira simples de construir um conjunto de excesso[2] Filtrar átomos aplicando recursivamente a decomposição acima a cada átomo de filtro, para expandir o espaço dos parâmetros para ajuste fino, conforme necessário.

3.3 Decomposição de camadas lineares

3.4 Parâmetro eficiente e eficiente

4 experimentos

Nesta seção, começamos o estudo da eficácia de nosso método em várias configurações para determinar o cenário de aplicação mais adequado para cada configuração. Posteriormente, demonstramos que apenas átomos de filtro de ajuste fino requer muito menos parâmetros, preservando a capacidade dos modelos pré-treinados, em comparação com os métodos de linha de base nos contextos de tarefas discriminativas e generativas.

4.1 Configurações experimentais

Conjuntos de dados. Nossas avaliações experimentais são conduzidas principalmente na referência de adaptação para tarefas visuais (VTAB) [76]que contém 19 tarefas distintas de reconhecimento visual provenientes de 16 conjuntos de dados. Como um subconjunto de VTAB, o VTAB-1K compreende apenas 1.000 exemplos de treinamento rotulados em cada conjunto de dados.

Modelos. Para o experimento de validação, escolhemos resnet50 [13] pré-treinado no imagenet-1k. Para tarefas discriminativas, escolhemos o modelo baseado em convolução, ConvNext-B [32] Pré-treinado no ImageNet-21K como inicialização para o Finetuning. Para tarefas generativas, escolhemos difusão estável [49] que contém um autoencoder de redução do fator 8 com um codificador de texto de 860m UNET e Clip Vit-L/14 como texto para o modelo de difusão. O modelo é pré-treinado no conjunto de dados Laion [54]que contém mais de 5 bilhões de pares de texto de imagem. Mais detalhes dos modelos pré -ridicularizados estão listados no Apêndice 7.

4.2 Experiências de validação

Nesta seção, estudamos o desempenho de nossa abordagem em várias configurações.

4.3 Tarefas generativas

Nesta seção, aplicamos nosso método à tarefa generativa, avaliando as amostras generativas do conjunto de dados VTAB [76].

Linhas de base. Comparamos nosso método com 6 abordagens de ajuste fino da linha de base: (i) ajuste fino completo, o que implica atualizar todos os parâmetros do modelo durante o processo de Finetuning; (ii) Lora [16]envolvendo a introdução de uma estrutura de baixo rank de atualização de gradiente acumulada, decompondo-a como projeção e abaixa. (iii) Loha [71] Utiliza o produto Hadamard em dois conjuntos de decomposições de Lowrank para elevar a classificação da matriz resultante e reduzir o erro de aproximação. (iv) Lokr [71] Introduz o produto Kronecker para decomposição da matriz para reduzir os parâmetros ajustáveis. (v) Bitfit [74] Tunes finos o termo viés de cada camada. (vi) Diffit [69] Tunes finas o termo de polarização, bem como a norma da camada e o fator de escala de cada camada.

Métodos como Lora [16] Ou o ajuste fino completo atualiza potencialmente esses α, assim, eles levam a menor diversidade e alinhamento de texto a imagem em imagens geradas. Por outro lado, Bitfit [74] e diffit [69] Tune principalmente o viés, deixando α fixo, portanto, eles têm uma diversidade mais alta e alinhamento de texto à imagem que Lora. No entanto, eles também mantêm a operação espacial D inalterada, resultando em uma pontuação de menor fidelidade em comparação com C2. Mais resultados podem ser encontrados no Apêndice 8.

Comparações de desempenho no aprendizado generativo de transferência. Relatamos fids de modelos treinados e avaliados em tarefas de VTAB na Tabela 3. Em contraste com o ajuste fino e a LORA completos, nossa abordagem atinge os escores mais baixos do FID (54,7 vs 57,5) enquanto empregamos o menor número de parâmetros de ajuste fino (1,11m vs 22,67m). Apesar do ajuste fino apenas 0,13% dos parâmetros totais do modelo, nosso método efetivamente adapta a difusão estável pré-treinada para alinhá-lo com a distribuição alvo desejada.

4.4 Tarefas discriminativas

Nesta seção, aplicamos nosso método à tarefa discriminativa, a saber, a classificação no VTAB-1K [76]. Comparamos nosso método com 4 abordagens de ajuste fino da linha de base: (i) ajuste fino completo, (ii) sondagem linear, (iii) bitfit [74]e (iv) Lora [16].

Detalhes da implementação. As imagens são redimensionadas para 224 × 224, seguindo as configurações padrão no VTAB [76]. Nós empregamos o Adamw [33] Otimizador para ajustar modelos de ajuste para 100 épocas. A estratégia de decaimento de cosseno é adotada para o cronograma da taxa de aprendizagem, e o aquecimento linear é usado nas 10 primeiras épocas.

Neste experimento, ajustamos D e DC, mantendo α e αC fixos, pois essa configuração fornece precisão adequada sem aumentar os parâmetros.

Comparações de desempenho no aprendizado de transferência de poucos tiros. Comparamos o desempenho de nossa abordagem e outros métodos de linha de base, e os resultados

No VTAB-1K, são mostrados na Tabela 4. Nessas tabelas, a fonte em negrito mostra a melhor precisão de todos os métodos e a fonte sublinhada mostra a segunda melhor precisão. Nosso método supera outros métodos de ajuste fino com eficiência de parâmetro e até supera o ajuste fino completo. Especificamente, nosso método obtém uma melhoria de 6% na precisão em comparação com o LORA no benchmark VTAB-1K, utilizando significativamente menos parâmetros treináveis (0,45m vs 17,4m).

O erro de generalização é medido pela discrepância entre a perda de treinamento e a perda de teste, com as descobertas ilustradas na Tabela 4 e na Figura 7 do Apêndice 8. Nossa técnica, que emprega coeficientes de átomo fixo, leva a um erro de generalização comparativamente menor. Isso significa que nosso método de ajuste preserva melhor a capacidade de generalização do modelo pré-treinado.

[1] O subespaço do filtro é uma extensão de m átomos de filtro D.

![Fig. 5: Difusão estável tune tune [49] Para aprender o conceito com (a) e gerar imagens usando o prompt de texto: “Um pavão na frente do”. (b) Imagens geradas pelo modelo pré-treinado, sem qualquer ajuste fino, alinham-se bem com o prompt de texto, mas não conseguem corresponder ao conceito de destino. (d) Quando apenas o ajuste fino dos átomos de filtro D, nossa abordagem alcança um bom alinhamento com o prompt de texto e o conceito de destino. (h) No entanto, o ajuste fino dos pesos do canal espacialmente invariante, ou seja, os coeficientes de átomos α, resulta em imagens geradas apenas alinhadas com o conceito de destino, comprometendo a capacidade do modelo pré-treinado de produzir imagens diversas alinhadas com o prompt de texto. Este problema também é observado em (por exemplo).](https://hackernoon.imgix.net/images/fWZa4tUiBGemnqQfBGgCPf9594N2-oi53202.png?auto=format&fit=max&w=3840)