Tabela de links

Resumo e 1. Introdução

- Método proposto: quantizado Dylora

- Experiências e avaliação

- Sobre o comportamento semi-derrotado de Qdylora

- Conclusão, limitações e referências

A. Material suplementar

A.1. Hyperparameters

A.2. Qualidade de texto gerada

2 Método proposto: quantizado Dylora

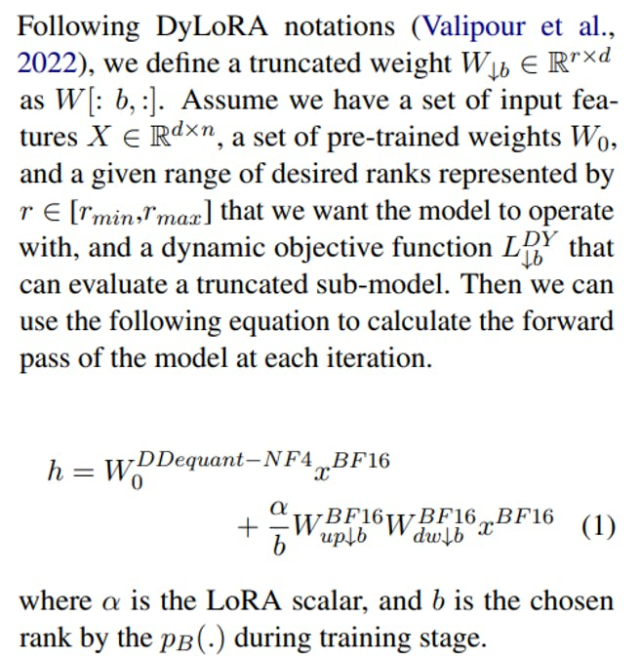

Seguindo Qlora (Dettmers et al., 2023), usamos flutuação normal de 4 bits (NF4) para armazenar os pesos pré-treinados quantizados duplos. Como todos os cálculos precisam ser calculados na precisão do BFLOAT16, o DDEQUANT-NF4 desquantizará os dados armazenados. Semelhante a (Dettmers et al., 2023), temos:

O algoritmo 1 descreve o fluxo de trabalho de nossa Qdylora proposta em detalhes.

3 experimentos e avaliação

Esta seção avalia a eficiência e a eficácia de Qdylora através de vários ajustes de fino de instrução

tarefas. O primeiro experimento compara Qdylora com Qlora em benchmark de subestimação de linguagem múltipla (MMLU) (Hendrycks et al., 2020), consistindo em mais de 50 tarefas diferentes, abrangendo da matemática fundamental e da história dos EUA à ciência da computação e à lei. Conforme mostrado na Tabela 1 [1]Nós finetune llama-7b, llama-13b, llama2-13b e falcon40b em diferentes conjuntos de dados, alpaca (Taori et al., 2023), Oasst1 (Köpf et al., 2023), auto-instrução (Wang et al., 2022), e flanv2 (CHUnn), 2023 (Wang22), 2023, e al. técnicas. Usamos o mesmo orçamento de treinamento e o máximo de Lora Rank[2] para cada técnica. Os resultados mostram consistentemente que Qdylora alcança um desempenho superior ao encontrar a classificação ideal.

O segundo experimento fornece uma comparação mais aprofundada entre Qlora e Qdylora. Em particular, Finetuned Falcon-40B razoavelmente fino no WebGLM (Liu et al., 2023) e GSM8K (Cobbe et al., 2021), e comparamos seus desempenhos de teste em diferentes fileiras. Conforme descrito na Tabela 2, o QDYLORA atinge o desempenho superior, principalmente ao empregar suas classificações ideais (classificação 2 para Web-GLM e Rank 8 para GSM8K). Além disso, Qdylora exibe superioridade consistente sobre a Qlora, particularmente em fileiras mais baixas. Esses achados enfatizam a natureza adaptativa da Qdylora em ajustar dinamicamente seu foco durante o ajuste fino, levando a maior eficiência e eficácia em comparação com sua contraparte estática, Qlora. O terceiro experimento compara o desempenho de Dylora, Qdylora e Qlora no GSM8K e Triviaqa (Joshi et al., 2017) enquanto adotava llama2-13b e llama-7b como LLMS. A Tabela 3 relata os resultados. Como a tabela ilustra, para modelos de tamanho menor, o IE llama-7b, Dylora e Qdylora têm desempenho superior que Qlora. Para modelos maiores, IE LLAMA2-13B, Dylora falha devido ao erro fora da memória (OOM), enquanto Qdylora funciona melhor em tais situações.

4 Sobre o comportamento semi-derrotado de Qdylora

Conforme mostrado na Tabela 2, Qdylora revela um desempenho semi -cortado nas fileiras. Justificamos esse comportamento, apontando o orçamento limitado do Finetuning. Em uma suposição orçamentária limitada, a QDYLORA atualiza suas classificações mais baixas com mais frequência do que suas classificações mais altas. Isso se deve ao fato de que as classificações mais baixas também são atualizadas quando as classificações mais altas são selecionadas. Em outras palavras, as classificações mais baixas têm mais chance de serem atualizadas do que as classificações mais altas. Portanto, as classificações mais baixas são mais ajustadas do que as classificações mais altas.

Este artigo é Disponível no Arxiv Sob atribuição de licença internacional de atribuição não comercial.

[1] As mesmas configurações que o trabalho de Qlora original são aplicadas aqui.

[2] A classificação máxima de Lora é fixada para 64. Enquanto a classificação de Qlora é sempre fixa, Qdylora pode dividir o treinamento nas fileiras na faixa de 1 a 64.