Tabela de links

Resumo e 1. Introdução

- Trabalho relacionado

- Metodologia

- Configuração experimental e resultados

- Conclusão e trabalho futuro

Agradecimentos

Declaração de reprodutibilidade

Declaração de impacto e referências

4. Configuração e resultados experimentais

Estendemos a referência experimental introduzida por Wu et al. (2023) em várias dimensões. Abaixo, descrevemos as opções de design de nossa referência e destacamos suas principais distinções do timesnet[5].

Modelagem de séries temporais com supervisão limitada. Nosso benchmark é composto por 5 principais tarefas de modelagem de séries temporais de valor prático significativo, a saber, previsão, imputação, classificação e detecção de anomalias, conforme descrito na guia. 1. Em contraste com o Timesnet, consideramos exclusivamente cenários caracterizados por recursos limitados de computação e supervisão. Esses cenários imitam situações práticas em que o treinamento (ou ajuste fino) uma rede neural profunda é inviável devido a limitações de recursos ou dados insuficientemente caracterizados. Consequentemente, avaliamos o momento em configurações de tiro zero sempre que viável e através de sondagem linear para algumas épocas.

Para classificação, consideramos o problema de aprendizado de representação não supervisionado, onde o objetivo é aprender representações de séries temporais que são úteis para a classificação a jusante, sem acesso a dados rotulados. Como é comum em trabalhos anteriores (Yue et al., 2022; Franceschi et al., 2019), a qualidade das representações é medida usando a precisão de uma máquina de vetor de suporte treinada nelas (App. E.2). Para previsão de horizonte curto, consideramos a configuração de tiro zero introduzido por Oreshkin et al. (2021). Em particular, estamos no momento definido em um conjunto de dados de origem usando uma cabeça de previsão,

e avalie seu desempenho em um conjunto de dados de destino sem qualquer ajuste fino (App e.1.2, guia 21).

Conjuntos de dados. Utilizamos os mesmos conjuntos de dados que o TimesNet para previsão e imputação. No entanto, para classificação e detecção de anomalia, realizamos experimentos em subconjunto de conjuntos de dados maiores e escolhidos sistematicamente do arquivo de classificação UCR (Dau et al., 2018) e o arquivo de anomalia da UCR (Wu & Keogh, 2023). Especificamente, executamos experimentos de classificação em todos os 91 conjuntos de dados de séries temporais a cada série do tempo menor que 512 etapas do tempo (TAB.23). Para a detecção de anomalia, ao escolher o subconjunto de séries temporais, priorizamos a cobertura sobre diferentes domínios e fontes de dados representadas no arquivo de anomalia da UCR (TAB 22). Também observamos que o arquivo de anomalia da UCR foi proposto como uma melhoria em relação aos conjuntos de dados de detecção de anomalias pré-existentes, como o SMD (Su et al., 2019) e SMAP (Hundman et al., 2018), muitos dos quais também são usados no Timesnet. Nossa configuração experimental proposta está resumida na guia. 1 e detalhado no aplicativo. E.

Métricas. Avaliamos cada experimento usando várias métricas usadas em benchmarks específicos de tarefas, como MSE e MAE para previsão de longo horizonte, e SMAPE para a previsão de horizonte curta. Também observamos que o timesNet e o GPT4TS (Zhou et al., 2023) avaliam o desempenho da detecção de anomalias usando a pontuação de baunilha F1 que ignora a natureza seqüencial das séries temporais. Em vez disso, medimos o desempenho da detecção de anomalia com o melhor escore F1 ajustado amplamente utilizado (Goswami et al., 2023a; Challu et al., 2022) e o recentemente proposto Vus-Roc (Paparrizos et al., 2022a).

Linhas de base. Comparamos o momento com os modelos de aprendizado profundo e de aprendizado de máquina de última geração nas tarefas (guia 35). Isso contrasta com o TimesNet, que comparou principalmente com abordagens baseadas em transformador. Essas comparações são cruciais para avaliar a utilidade prática dos métodos propostos. Descobrimos que abordagens estatísticas e não baseadas em transformador, como a ARIMA, para previsão do Shorthorizon, batidas de N para previsão de longo horizonte e vizinhos mais antigos para a detecção de anomalias superam muitos modelos profundos e baseados em transformadores.

Ajuste hiper-parâmetro. Não realizamos ajuste hiperparâmetro. Em todas as experiências que se seguem, a menos que mencionadas o contrário, ajustamos o momento em que o Moment-grande com um tamanho de lotes de 64 e um cronograma de taxa de aprendizado de ciclo com uma taxa de aprendizado de pico entre 5e-5 e 1e-3 (Smith & Topin, 2019). Para métodos de linha de base, capturamos configurações recomendadas de seus documentos e repositórios públicos. Relatamos todas as configurações de hiper-parâmetros para o momento e as linhas de base no aplicativo. E.

Questões de pesquisa. Através dos seguintes experimentos, pretendemos responder a três amplas perguntas de pesquisa.

RQ1: eficácia. O momento é eficaz para várias tarefas de análise de séries temporais em configurações de supervisão limitadas?

RQ2: Interpretabilidade. O que é o momento do momento? Ele captura características intuitivas de séries temporais, como frequências, tendências e amplitudes variadas?

RQ3: Propriedades. Qual é o impacto do tamanho do tamanho do modelo de escala? O momento, semelhante ao LLMS, pode ser usado para o aprendizado de transferência cruzada?

4.1. O momento pode resolver várias tarefas de modelagem de séries temporais em configurações de supervisão limitadas

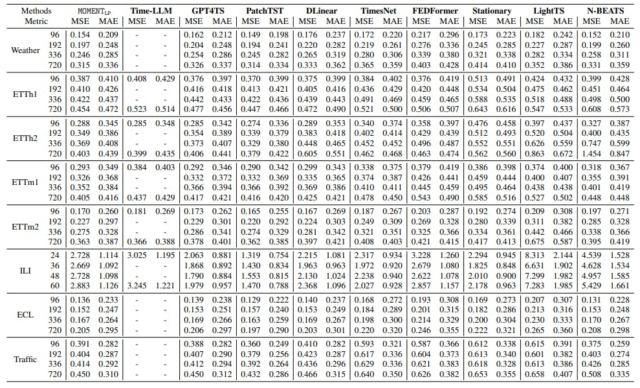

Previsão de longo horizonte. O momento de sondagem linearmente atinge o desempenho próximo à arte na maioria dos conjuntos de dados e horizontes e é apenas o segundo para patchtst, que geralmente atinge o MSE mais baixo (TAB. 2). Em muitos conjuntos de dados e horizontes, a previsão de modelos baseados em LLMS – Timellm e GPT4Ts funcionam pior que o momento. Notavelmente, o NBEATS supera vários métodos recentes, enfatizando a importância de comparar a previsão do desempenho além das abordagens baseadas em transformador.

Previsão de horizonte curto com tiro zero. Entre todas as tarefas, descobrimos que a previsão de horizonte curta zero tem o maior escopo de melhoria (guia 3). Métodos estatísticos como Theta e ETs superaram seus colegas mais profundos. No entanto, em alguns conjuntos de dados, o momento alcançou Smape mais baixa que ARIMA.

Classificação. Sem qualquer ajuste fino específico de dados, o Moment pode aprender representações distintas para diferentes classes de dados (Fig. 5), e um SVM treinado em suas representações tem um desempenho melhor do que todos os 4 métodos, especificamente criados para modelos de classificação de séries temporais e treinados em cada conjunto de dados individual. Recentemente, propostos, o GPT4TS e o Timesnet têm um desempenho ruim, apesar de terem sido treinados em cada conjunto de dados individuais com rótulos.

Detecção de anomalia. Em 44 séries temporais do arquivo de detecção de anomalia UCR, o momento superou consistentemente o timesNet e o GPT4TS, bem como 2 modelos de aprendizado profundo de última geração adaptados para detecção de anomalia, tanto em configurações de sondagem zero e linear. No entanto, os vizinhos mais parecidos com o K-Kest tiveram um desempenho marginalmente melhor em termos de pontuação VUS-ROC, mas tiveram uma pontuação F1 mais baixa ajustada.

Imputação. Guia. 6 Contém o desempenho da imputação de todos os modelos em média em 4 taxas de mascaramento diferentes. O momento com sondagem linear alcançou o menor erro de reconstrução em todos os conjuntos de dados ETT. Na configuração de tiro zero, o momento superou consistentemente todos os métodos de interpolação estatística, com exceção da interpolação linear.

4.2. O que é o momento do momento?

Descobrimos que o momento pode capturar mudanças nas características intuitivas de séries temporais, como tendência, amplitude, frequências e fases das séries temporais. No entanto, não pode diferenciar as séries temporais mudadas verticalmente, pois normaliza cada sinal antes da modelagem (Fig. 4,7). Além disso, em muitos conjuntos de dados de classificação, o momento aprende representações distintas de diferentes classes, mesmo em uma configuração de tiro zero sem acesso a rótulos (Fig. 5, 8).

4.3. Propriedades de grandes modelos de séries temporais

A escala do modelo melhora a perda de treinamento. Como o LLMS, descobrimos que aumentar o tamanho do modelo leva a uma menor perda de treinamento, mesmo antes da primeira época (Fig. 6, à esquerda). Uma próxima etapa imediata é avaliar a eficácia desse fenômeno às tarefas de modelagem de séries temporais sob supervisão limitada.

O momento pode resolver tarefas de aprendizado de sequência cruzada modal. Lu et al. (2022) mostraram primeiro que grandes transformadores de linguagem e visão pré-treinados podem resolver tarefas gerais de aprendizado de sequência para modalidades fora do texto e imagens com o mínimo de ajuste fino. Vários estudos recentes aproveitaram essas propriedades para reprogramar o LLMS para tarefas de séries temporais. Exploramos se os Transformers pré-treinados em séries temporais também podem ser usados para resolver tarefas de classificação de sequência em dados de imagem, texto e binários. Nossos resultados confirmam que, congelando as camadas de auto-atendimento e avanço, o momento pode modelar sequências comparáveis aos modelos GPT-2 e Flan-T5 de escala semelhante (guia 5).

O momento com pesos aleatoriamente inicializados converge para uma menor perda de treinamento. Nossas observações sugerem que, com dados suficientes, o pré-treinamento de nosso modelo do Scratch resulta em uma perda de treinamento mais baixa do que o pré-treinamento continuamente um modelo de tamanho semelhante inicializado com os pesos de modelagem de idiomas (Fig. 6, 12). Isso também ressalta que existem dados pré-treinamento suficientes acessíveis ao público disponíveis na pilha de séries temporais para facilitar os modelos de fundação de séries temporais pré-treinamento do zero.

Autores:

(1) Mononito Goswami, Auton Lab, Robotics Insititute, Carnegie Mellon University, Pittsburgh, EUA ([email protected])

(2) Konrad Szafer, Auton Lab, Robotics Institute, Carnegie Mellon University, Pittsburgh, EUA, com igual contribuição, a ordem decidiu usar um gerador aleatório;

(3) Arjun Choudhry, Auton Lab, Robotics Institute, Carnegie Mellon University, Pittsburgh, EUA, com igual contribuição, a ordem decidiu usar um gerador aleatório;

(4) Yifu Cai, Auton Lab, Robotics Institute, Carnegie Mellon University, Pittsburgh, EUA;

(5) Shuo Li, Universidade da Pensilvânia, Filadélfia, EUA;

(6) Artur Dubrawski, Auton Lab, Robotics Institute, Carnegie Mellon University, Pittsburgh, EUA.

[5] Nesta seção, usamos o TimesNet para nos referir à referência proposta por Wu et al. (2023) em vez de seu modelo.